序文

これまでの Web 上のオーディオはかなり未発達なもので、ごく最近まで Flash や QuickTime のようなプラグインを通して配信しなくてはなりませんでした。HTML5 での audio 要素の導入は、基本的なストリーミング・オーディオ再生を可能にする重要なものです。しかし、より複雑なオーディオアプリケーションを扱うには、それだけではまだ充分に強力ではありません。洗練された Web ベースのゲームやインタラクティブ・アプリケーションのためには別の解決策が必要とされます。この仕様では、近年のデスクトップ・オーディオ制作アプリケーションに見られるミキシング、プロセシング、フィルタリング処理に加え、近年のゲームオーディオエンジンに見られるような機能も持たせる事を目標とします。

この API はさまざまな使用例 [webaudio-usecases] を考慮して設計されています。理想的にはすべての使用例が、JavaScript から制御される最適化された C++ エンジンを使って無理なく実装でき、ブラウザーで動作するようにサポートされなくてはなりません。とは言っても、近年のデスクトップ・オーディオソフトウェアは極めて高度な機能を持ち、それらの一部はこのシステムを使ったとしても構築する事が困難か不可能と考えられます。Apple 社の Logic Audio がそのようなアプリケーションの 1 つであり、外部 MIDI コントローラー、任意のプラグイン・オーディオエフェクトやシンセサイザー、高度に最適化されたオーディオファイルのディスクへの読み込み/書き出し、密に統合されたタイムストレッチなどなどをサポートしています。それでもなお、ここで提案するシステムは、音楽に関するものを含めて、かなり複雑なゲームやインタラクティブ・アプリケーションの広い範囲を充分にサポートする事が可能です。またそれは、WebGL によってもたらされる、より高度なグラフィックスの機能をよく引き立たせる事が可能です。このAPIはより高度な機能を後から追加できるように設計されています。

機能

この API は、これらの基本機能をサポートします:

-

単純な、または 複数のセンド、サブミックス を含む複雑なミキシング/エフェクト・アーキテクチャーのための モジュラールーティング

-

内部処理に 32 ビット浮動小数を使用した高いダイナミックレンジ

-

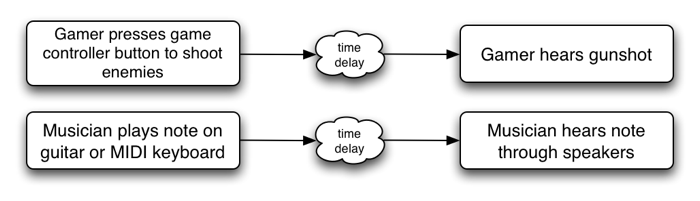

非常に高度なリズムの精度を必要とするドラムマシンやシーケンサーなどのアプリケーションのための、低 レイテンシー な サンプル単位の時間精度での音の再生。これには、エフェクトを 動的に生成 できるようにする事も含まれます

-

エンベロープ、フェードイン/フェードアウト、グラニュラーエフェクト、フィルタースイープ、LFO などのためのオーディオパラメーターのオートメーション

-

分割や結合など、オーディオストリームのチャンネルに対する柔軟な扱い

-

audioまたはvideomedia elementからのオーディオに対する処理 -

getUserMedia() からの

MediaStreamを使用したライブオーディオ入力に対する処理 -

WebRTC との統合

-

MediaStreamTrackAudioSourceNodeと [webrtc] を使ってリモート・ピアから受け取ったオーディオの処理 -

生成または加工されたオーディオストリームの

MediaStreamAudioDestinationNodeと [webrtc] を使ったリモート・ピアへの送信

-

-

Script での直接的 なオーディオストリームの合成および加工

-

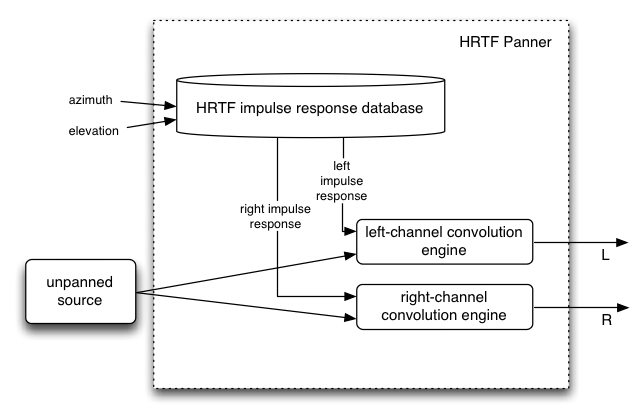

3D ゲームや没入環境を幅広くサポートする 空間音響 :

-

パンニングモデル: 等価パワー, HRTF, パススルー

-

距離減衰

-

サウンドコーン

-

障害物 / 遮蔽物

-

ソース / リスナー

-

-

広範囲の線形エフェクト、特に非常に高い品質のルーム・エフェクトに使用できるコンボリューションエンジン。これによって可能なエフェクトの例を以下に示します:

-

小さい / 大きい部屋

-

大聖堂

-

コンサートホール

-

洞窟

-

トンネル

-

廊下

-

森

-

野外劇場

-

出入り口を経由した遠くの部屋

-

極端なフィルター

-

風変りな巻き戻し効果

-

極端なコムフィルター効果

-

-

ミックス全体の制御やスウィートニング ( 訳注:ビデオに効果音などをつける MA 作業 ) のためのダイナミック・コンプレッション

-

効率的な双二次フィルターによる、ローパス、ハイパス、その他一般的なフィルター

-

ディストーションやその他の非線形エフェクトのためのウェーブシェイピング・エフェクト

-

オシレーター

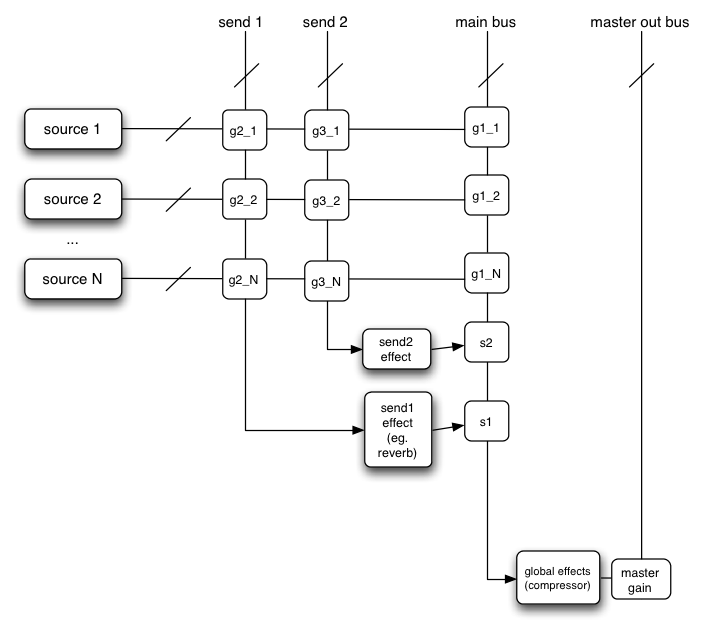

モジュラールーティング

モジュラールーティングによって異なる AudioNode オブジェクト同士を任意に接続できます。それぞれのノードは入力および出力を持っています。

ソースノードは入力は持たず、ひとつの出力を持ちます。

デスティネーションノードはひとつの入力を持ち、出力は持っていません。フィルターなどの他のノードはソースとデスティネーションの間に配置することができます。2 つのオブジェクトが互いに接続している場合、低レベルのストリーム形式の詳細について開発者が煩わされる事なく、適正な処理が行われます。

例えばもしモノラルの音声ストリームがステレオの入力に接続されていても、左右のチャンネルに 適正 にミックスされます。

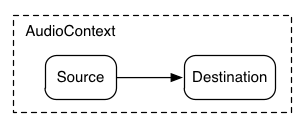

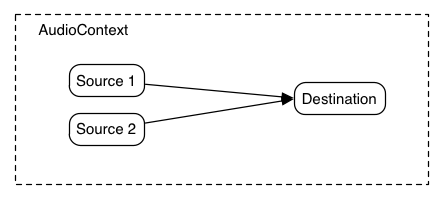

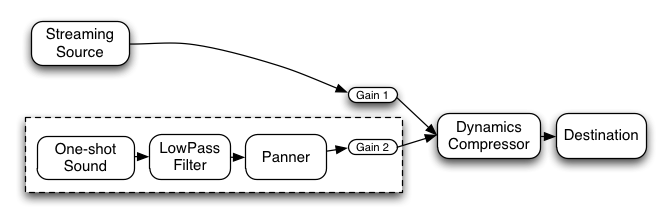

最も単純な例は、ひとつの音声ソースを出力に直接接続したものです。すべての接続は単一の AudioDestinationNode を持つ AudioContext 内部で行われます:

この単純なルーティングを図示します。この例では単一の音を再生しています:

var context= new AudioContext(); function playSound() { var source= context. createBufferSource(); source. buffer= dogBarkingBuffer; source. connect( context. destination); source. start( 0 ); }

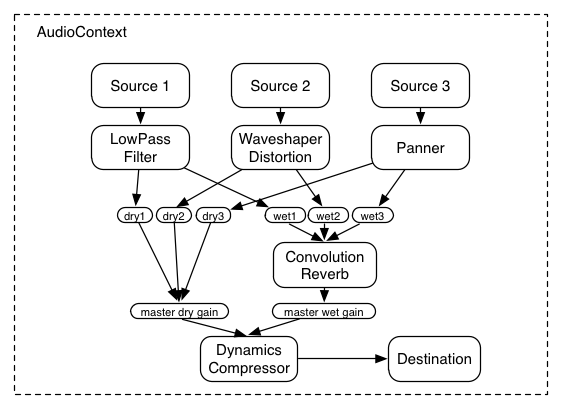

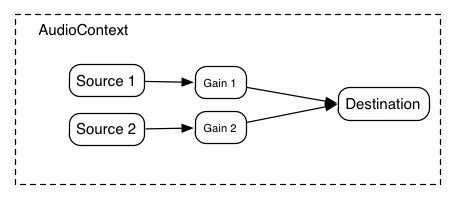

これはもっと複雑な例で、3 つのソースとコンボリューションリバーブが最終出力段にあるダイナミックコンプレッサーを介して送られます:

var context= 0 ; var compressor= 0 ; var reverb= 0 ; var source1= 0 ; var source2= 0 ; var source3= 0 ; var lowpassFilter= 0 ; var waveShaper= 0 ; var panner= 0 ; var dry1= 0 ; var dry2= 0 ; var dry3= 0 ; var wet1= 0 ; var wet2= 0 ; var wet3= 0 ; var masterDry= 0 ; var masterWet= 0 ; function setupRoutingGraph() { context= new AudioContext(); // Create the effects nodes. lowpassFilter= context. createBiquadFilter(); waveShaper= context. createWaveShaper(); panner= context. createPanner(); compressor= context. createDynamicsCompressor(); reverb= context. createConvolver(); // Create master wet and dry. masterDry= context. createGain(); masterWet= context. createGain(); // Connect final compressor to final destination. compressor. connect( context. destination); // Connect master dry and wet to compressor. masterDry. connect( compressor); masterWet. connect( compressor); // Connect reverb to master wet. reverb. connect( masterWet); // Create a few sources. source1= context. createBufferSource(); source2= context. createBufferSource(); source3= context. createOscillator(); source1. buffer= manTalkingBuffer; source2. buffer= footstepsBuffer; source3. frequency. value= 440 ; // Connect source1 dry1= context. createGain(); wet1= context. createGain(); source1. connect( lowpassFilter); lowpassFilter. connect( dry1); lowpassFilter. connect( wet1); dry1. connect( masterDry); wet1. connect( reverb); // Connect source2 dry2= context. createGain(); wet2= context. createGain(); source2. connect( waveShaper); waveShaper. connect( dry2); waveShaper. connect( wet2); dry2. connect( masterDry); wet2. connect( reverb); // Connect source3 dry3= context. createGain(); wet3= context. createGain(); source3. connect( panner); panner. connect( dry3); panner. connect( wet3); dry3. connect( masterDry); wet3. connect( reverb); // Start the sources now. source1. start( 0 ); source2. start( 0 ); source3. start( 0 ); }

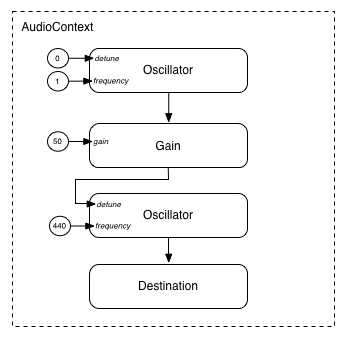

モジュラールーティングはまた AudioNode の出力を 別の AudioNode の動きを制御する AudioParam パラメーターに接続する事もできます。この場合は、ノードからの出力は 入力信号ではなくモジュレーション信号として働きます。

function setupRoutingGraph() { var context= new AudioContext(); // Create the low frequency oscillator that supplies the modulation signal var lfo= context. createOscillator(); lfo. frequency. value= 1.0 ; // Create the high frequency oscillator to be modulated var hfo= context. createOscillator(); hfo. frequency. value= 440.0 ; // Create a gain node whose gain determines the amplitude of the modulation signal var modulationGain= context. createGain(); modulationGain. gain. value= 50 ; // Configure the graph and start the oscillators lfo. connect( modulationGain); modulationGain. connect( hfo. detune); hfo. connect( context. destination); hfo. start( 0 ); lfo. start( 0 ); }

API の概要

定義されているインターフェイスは次のとおりです:

-

AudioContext インターフェイスは、

AudioNode間の接続を表すオーディオ信号グラフを保持します。 -

AudioNodeインターフェイスは、オーディオのソース、オーディオの出力、その間にある処理モジュールを表します。AudioNodeは モジュラー方式 で動的に互いに接続されます。AudioNodeはAudioContextのコンテキスト内に存在します。 -

AnalyserNodeインターフェイスは、ミュージックビジュアライザーやその他の視覚化アプリケーションで使用されるAudioNodeです。 -

AudioBufferインターフェイスは、メモリー内に保持されるオーディオのリソースで使用されます。これらはワンショットの音、またはもっと長いオーディオクリップを表します。 -

AudioBufferSourceNodeインターフェイスは、AudioBuffer からの音を発生するAudioNodeです。 -

AudioDestinationNodeインターフェイスは、AudioNodeのサブクラスでオーディオの最終的な出力地点を表します。 -

AudioParamインターフェイスは、AudioNodeの個別の機能、例えば音量などを制御します。 -

AudioListenerインターフェイスは、PannerNodeと共に空間音響のために使用されます。 -

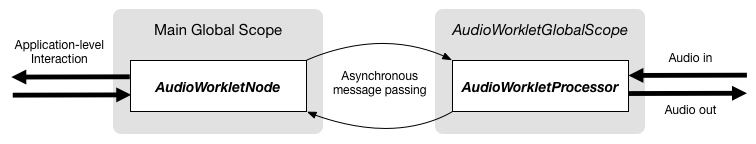

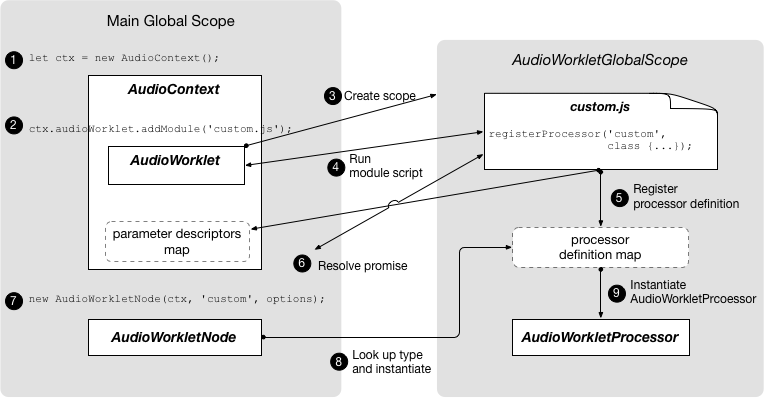

AudioWorkletインターフェイスは、スクリプトでオーディオを直接処理するカスタムノードを作成するファクトリーを表します。 -

AudioWorkletGlobalScopeインターフェイスは、AudioWorkletProcessor の処理スクリプトが実行されるコンテキストです。 -

AudioWorkletNodeインターフェイスは、AudioWorkletProcessor で処理されるAudioNodeを表します。 -

AudioWorkletProcessorインターフェイスは、Audio ワーカー内の 1 つのノードのインスタンスを表します。 -

BiquadFilterNodeインターフェイスは、次のような一般的な低次のフィルターのAudioNodeです:-

ローバス

-

ハイパス

-

バンドパス

-

ローシェルフ

-

ハイシェルフ

-

ピーキング

-

ノッチ

-

オールパス

-

-

ChannelMergerNodeインターフェイスは、複数のオーディオストリームからひとつのオーディオストリームにチャンネルの結合を行うAudioNodeです。 -

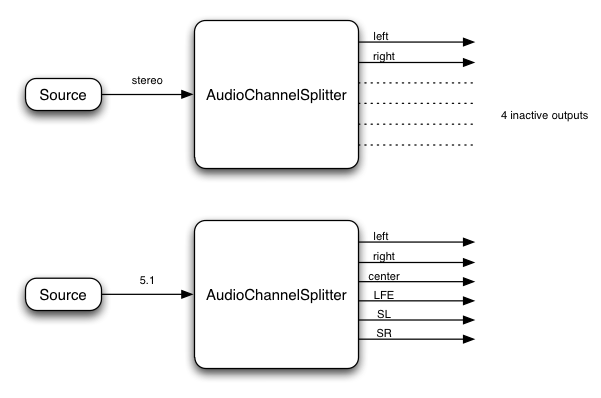

ChannelSplitterNodeインターフェイスは、ルーティンググラフ内のオーディオストリームの個別のチャンネルにアクセスするために使用されるAudioNodeです。 -

ConstantSourceNodeインターフェイスは、AudioParamによる値のオートメーションが可能な定数値を出力するAudioNodeです。 -

ConvolverNodeインターフェイスは、( 例えばコンサートホールでの音のような ) リアルタイム線形エフェクトを加えるAudioNodeです。 -

DynamicsCompressorNodeインターフェイスは、ダイナミクス・コンプレッションのためのAudioNodeです。 -

GainNodeインターフェイスは、明示的なゲイン制御を行うAudioNodeです。AudioNodeへの入力は (ユニティー・ゲインの加算による) 複数の接続をサポートしているため、GainNode を使う事でミキサーが 簡単に構成 できます。 -

IIRFilterNodeインターフェイスは、一般的な IIR フィルターのAudioNodeです。 -

MediaElementAudioSourceNodeインターフェイスは、audio、videoその他のメディア要素を音源とするAudioNodeです。 -

MediaStreamAudioSourceNodeインターフェイスは、ライブオーディオ入力やリモート・ピアから受け取ったような MediaStream を音源とするAudioNodeです。 -

MediaStreamTrackAudioSourceNodeインターフェイスは、MediaStreamTrack からのオーディオを音源とするAudioNodeです。 -

MediaStreamAudioDestinationNodeインターフェイスは、リモート・ピアに送信する MediaStream を出力先とするAudioNodeです。 -

PannerNodeインターフェイスは、3D 空間での空間音響/空間定位のためのAudioNodeです。 -

PeriodicWaveインターフェイスは、OscillatorNodeで使用されるカスタム周期波形を指定するために使用されます。 -

OscillatorNodeインターフェイスは、周期的な波形を発生するAudioNodeです。 -

StereoPannerNodeインターフェイスは、ステレオストリームで 入力された信号の equal-power 方式の定位を行うAudioNodeです。 -

WaveShaperNodeインターフェイスは、例えばディストーションや微妙なウォーミング効果 ( 訳注:いわゆるサチュレーション効果の事 ) など、非線形のウェーブシェイピング・エフェクトを加えるためのAudioNodeです。

また非推奨ですがまだ削除されておらず、置き換えの実装が予定されているいくつかの Web Audio API があります。

-

ScriptProcessorNodeインターフェイスは、スクリプトでオーディオを直接生成または処理するためのAudioNodeです。 -

AudioProcessingEventインターフェイスは、ScriptProcessorNodeオブジェクトと共に用いられるイベントタイプです。

1. オーディオ API

1.1. BaseAudioContext インターフェイス

このインターフェイスは AudioNode オブジェクトのセットとそれらの接続を表します。それによって AudioDestinationNode に任意の信号をルーティングする事を可能にします。ノードはコンテキストから作成され、お互いに connected されます。

BaseAudioContext は直接的にはインスタンス化されず、代わりに AudioContext (リアルタイムレンダリングの場合)と OfflineAudioContext (オフラインレンダリングの場合)が拡張された具体的なインターフェイスとなっています。

enum {AudioContextState "suspended" ,"running" ,"closed" };

| 列挙値の説明 | |

|---|---|

"suspended"

| このコンテキストは現在中断 ( コンテキストの時間は進まず、オーディオハードウェアはパワーダウン / 解放 ) しています。 |

"running"

| オーディオは処理状態にあります。 |

"closed"

| このコンテキストは解放され、もうオーディオ処理に使用できません。すべてのシステムオーディオリソースは解放されました。 |

callback DecodeErrorCallback =void (DOMException );error callback DecodeSuccessCallback =void (AudioBuffer ); [decodedData Exposed =Window ]interface :BaseAudioContext EventTarget {readonly attribute AudioDestinationNode destination ;readonly attribute float sampleRate ;readonly attribute double currentTime ;readonly attribute AudioListener listener ;readonly attribute AudioContextState state ; [SameObject ,SecureContext ]readonly attribute AudioWorklet audioWorklet ;attribute EventHandler onstatechange ;AnalyserNode createAnalyser ();BiquadFilterNode createBiquadFilter ();AudioBuffer createBuffer (unsigned long ,numberOfChannels unsigned long ,length float );sampleRate AudioBufferSourceNode createBufferSource ();ChannelMergerNode createChannelMerger (optional unsigned long numberOfInputs = 6);ChannelSplitterNode createChannelSplitter (optional unsigned long numberOfOutputs = 6);ConstantSourceNode createConstantSource ();ConvolverNode createConvolver ();DelayNode createDelay (optional double maxDelayTime = 1.0);DynamicsCompressorNode createDynamicsCompressor ();GainNode createGain ();IIRFilterNode createIIRFilter (sequence <double >,feedforward sequence <double >);feedback OscillatorNode createOscillator ();PannerNode createPanner ();PeriodicWave createPeriodicWave (sequence <float >,real sequence <float >,imag optional PeriodicWaveConstraints );constraints ScriptProcessorNode createScriptProcessor (optional unsigned long bufferSize = 0,optional unsigned long numberOfInputChannels = 2,optional unsigned long numberOfOutputChannels = 2);StereoPannerNode createStereoPanner ();WaveShaperNode createWaveShaper ();Promise <AudioBuffer >decodeAudioData (ArrayBuffer ,audioData optional DecodeSuccessCallback ?,successCallback optional DecodeErrorCallback ?);errorCallback Promise <void >resume (); };

1.1.1. 属性

audioWorklet, AudioWorklet 型, readonly-

[worklets-1] と

AudioWorkletのアルゴリズムにより定義されたAudioWorkletProcessorクラスのスクリプトをインポート可能なWorkletオブジェクトへのアクセスを行います。 currentTime, double 型, readonly-

コンテキストのレンダリンググラフで最後に処理されたオーディオブロックの最後のサンプルフレームの次のサンプルの秒で表した時刻です。もしコンテキストのレンダリンググラフがまだオーディオブロックを処理していない場合

currentTimeは 0 になります。currentTimeの時間軸で 0 はグラフで処理される最初のブロックの最初のサンプルフレームに対応します。このシステムの経過時間はBaseAudioContextが生成するオーディオストリームの経過時間に対応し、それはシステム内の他の時計には同期しないかも知れません。(OfflineAudioContextでは、ストリームはどのデバイスも能動的に再生しないため、実時間とはまったく違う進み方になります )Web Audio API のすべてのスケジュールされた時刻は

currentTimeに対する相対値になります。BaseAudioContextが "running" 状態にあるとき、この属性は単調増加し、レンダリングスレッドにより 1 レンダリング量子 に対応する均一な増分で更新されます。そのため動作中のコンテキストでは、currentTimeはシステムがオーディオブロックを処理するに従って徐々に増加し、常に次に処理されるオーディオブロックの先頭の時刻を表します。それはまた現在の状態に対する変更が効力を持つ最も早い時刻でもあります。currentTimeは制御スレッドが戻るまでに アトミック に読み取られなくてはなりません ( MUST )。 destination, AudioDestinationNode 型, readonly-

AudioDestinationNodeは単一の入力を持ち、すべてのオーディオの最終的な出口を表しています。通常これは実際のオーディオハードウェアを表します。動作中のすべてのAudioNodeは直接または間接的にこのdestinationに接続されます。 listener, AudioListener 型, readonly-

AudioListenerは 3D 空間音響 で使用されます。 onstatechange, EventHandler 型-

BaseAudioContextに AudioContext の状態が変化したとき ( 例えば、対応する Promise がリゾルブされたときなど ) にディスパッチされるイベントのEventHandlerを設定するために使用されるプロパティです。 AudioContext の状態を直接問い合わせる事ができるEvent型のイベントがイベントハンドラーに発行されます。 新たに作成された AudioContextは 常にsuspended状態から開始し、状態の変化イベントは異なる状態への遷移の度に発行されます。このイベントはoncompleteイベントが発行される前に発行されます。 sampleRate, float 型, readonly-

BaseAudioContextが扱うオーディオのサンプルレート ( 1 秒あたりのサンプルフレーム数 ) です。コンテキスト内のすべてのAudioNodeはこのレートで動作する事を想定しています。これを想定するため、サンプレートコンバータや " 可変速 " 処理はリアルタイム処理内ではサポートされません。 ナイキスト周波数 はこのサンプルレートの半分の値となります。 state, AudioContextState 型, readonly-

制御スレッド における

AudioContextの現在の状態を表します。

1.1.2. メソッド

createAnalyser()-

AnalyserNodeの ファクトリーメソッド です。パラメーターなし戻り値:AnalyserNode createBiquadFilter()-

いくつかのタイプのフィルターに設定可能な 2 次フィルターを表す

BiquadFilterNodeの ファクトリーメソッド です。パラメーターなし戻り値:BiquadFilterNode createBuffer(numberOfChannels, length, sampleRate)-

与えられたサイズの AudioBuffer を作成します。バッファー内のデータは 0 ( 無音 ) で初期化されます。もし、引数のどれかが負、0 または範囲外の場合、

NotSupportedError例外を発生します ( MUST )。BaseAudioContext.createBuffer() メソッドの引数 パラメーター 型 Null可 省略可 説明 numberOfChannelsunsigned long ✘ ✘ バッファーが持つチャンネル数を指定します。実装は少なくとも 32 チャンネルをサポートしなくてはなりません ( MUST )。 lengthunsigned long ✘ ✘ バッファーのサイズをサンプルフレーム数で指定します。 sampleRatefloat ✘ ✘ バッファー内のリニア PCM オーディオデータのサンプルレートを秒あたりのサンプルフレーム数で表します。実装は少なくとも 8000 から 96000 の範囲をサポートしなくてはなりません ( MUST )。 戻り値:AudioBuffer createBufferSource()-

AudioBufferSourceNodeの ファクトリーメソッド です。パラメーターなし createChannelMerger(numberOfInputs)-

チャンネルマージャーを表す

ChannelMergerNodeの ファクトリーメソッド です。numberOfInputsが 1 より小さいかサポートされる数より大きい場合はIndexSizeError例外を発生します ( MUST )。BaseAudioContext.createChannelMerger(numberOfInputs) メソッドの引数 パラメーター 型 Null可 省略可 説明 numberOfInputsunsigned long ✘ ✔ 入力の数を指定します。値は 32 までサポートされなくてはなりません ( MUST )。もし指定されない場合は 6となります。戻り値:ChannelMergerNode createChannelSplitter(numberOfOutputs)-

チャンネルスプリッターを表す

ChannelSplitterNodeの ファクトリーメソッド です。numberOfOutputsが 1 より小さいかサポートされる数より大きい場合は、IndexSizeError例外を発生します ( MUST )。BaseAudioContext.createChannelSplitter(numberOfOutputs) メソッドの引数 パラメーター 型 Null可 省略可 説明 numberOfOutputsunsigned long ✘ ✔ 出力の数を指定します。値は 32 までサポートされなくてはなりません ( MUST )。もし指定されない場合は 6となります。戻り値:ChannelSplitterNode createConstantSource()-

ConstantSourceNodeの ファクトリーメソッド です。パラメーターなし戻り値:ConstantSourceNode createConvolver()-

ConvolverNodeの ファクトリーメソッド です。パラメーターなし戻り値:ConvolverNode createDelay(maxDelayTime)-

DelayNodeの ファクトリーメソッド です。初期化時のデフォルト遅延時間は 0 秒です。BaseAudioContext.createDelay(maxDelayTime) メソッドの引数 パラメーター 型 Null可 省略可 説明 maxDelayTimedouble ✘ ✔ 遅延機能の遅延時間の最大値を秒で指定します。指定する場合は、その値は 0 よりも大きく 3 分よりも小さくなければなりません ( MUST )。そうでない場合 NotSupportedError例外を発生します ( MUST )。 指定しない場合は1となります。戻り値:DelayNode createDynamicsCompressor()-

DynamicsCompressorNodeの ファクトリーメソッド です。パラメーターなし createGain()-

GainNodeの ファクトリーメソッド です。パラメーターなし戻り値:GainNode createIIRFilter(feedforward, feedback)-

BaseAudioContext.createIIRFilter() メソッドの引数 パラメーター 型 Null可 省略可 説明 feedforwardsequence<double> ✘ ✘ IIR フィルターの伝達関数のフィードフォワード ( 分子 ) の係数の配列です。この配列の最大の長さは 20 です。もしすべての値が 0 の場合、 InvalidStateError例外を発生します ( MUST )。 配列の長さが 0 または 20 より大きい場合はNotSupportedError例外を発生します ( MUST )。feedbacksequence<double> ✘ ✘ IIR フィルターの伝達関数のフィードバック ( 分母 ) の係数の配列です。この配列の最大の長さは20です。もし配列の最初の要素が 0 の場合、 InvalidStateError例外を発生します ( MUST )。 もし配列の長さが 0 または 20 より大きい場合はNotSupportedError例外を発生します ( MUST )。戻り値:IIRFilterNode createOscillator()-

OscillatorNodeの ファクトリーメソッド です。パラメーターなし戻り値:OscillatorNode createPanner()-

PannerNodeの ファクトリーメソッド です。パラメーターなし戻り値:PannerNode createPeriodicWave(real, imag, constraints)-

PeriodicWaveを作成する ファクトリーメソッド です。このメソッドを呼び出したとき、以下の手順が実行されます:-

もし

realとimagが同じ長さでない場合、IndexSizeErrorが発生します ( MUST )。 -

o を

PeriodicWaveOptions型の新しいオブジェクトとします。 -

このファクトリーメソッドに各々渡された

realおよびimagパラメーターを、o の同じ名前の属性としてセットします。 -

o の

disableNormalization属性を、ファクトリーメソッドに渡されたconstraints属性のdisableNormalizationの値にセットします。 -

このファクトリーメソッドが呼ばれた

BaseAudioContextを最初の引数とし、o を渡して新しいPeriodicWavep を作成します。 -

p を返します。

BaseAudioContext.createPeriodicWave() メソッドの引数 パラメーター 型 Null可 省略可 説明 realsequence<float> ✘ ✘ コサインパラメーターの数値列です。詳細の説明についてはコンストラクタの引数 realを参照してください。imagsequence<float> ✘ ✘ サインパラメーターの数値列です。詳細の説明についてはコンストラクタの引数 imagを参照してください。constraintsPeriodicWaveConstraints ✘ ✔ 指定されていない場合は、波形は正規化されます。そうでない場合、波形は constraintsに与えられた値に従って正規化されます。戻り値:PeriodicWave -

createScriptProcessor(bufferSize, numberOfInputChannels, numberOfOutputChannels)-

ScriptProcessorNodeの ファクトリーメソッド です。このメソッドは廃止予定 ( DEPRECATED ) で、code class="idl">AudioWorkletNode で置き換えられます。 スクリプトによるオーディオデータ直接処理のためのScriptProcessorNodeを作成します。bufferSizeまたはnumberOfInputChannelsまたはnumberOfOutputChannelsが範囲外の場合、IndexSizeError例外を発生します ( MUST )。numberOfInputChannelsとnumberOfOutputChannelsの両方を 0 にしてはいけません。この場合、IndexSizeError例外を発生します ( MUST )。BaseAudioContext.createScriptProcessor(bufferSize, numberOfInputChannels, numberOfOutputChannels) メソッドの引数 パラメーター 型 Null可 省略可 説明 bufferSizeunsigned long ✘ ✔ bufferSizeパラメーターはサンプルフレーム数でバッファーのサイズを指定します。もしそれが渡されない場合、または値が 0 である場合、実装はノードのライフタイムを通して一定な、動作環境に最適な2の累乗のバッファーサイズを選択します。それ以外の場合は明示的にバッファーサイズを指定します。それは次の値のどれかでなければなりません: 256、512、1024、2048、4096、8192、16384 ( MUST )。この値はonaudioprocessイベントが発生する頻度とそれぞれの呼び出しでどれだけのサンプルフレームを処理する必要があるかを制御します。bufferSizeが小さい値ならば レイテンシー は低く ( 良く ) なります。オーディオが途切れ、グリッジ が発生する事を避けるには大きな値が必要となります。レイテンシー とオーディオ品質の間のバランスを取るためには、プログラマーはこのバッファーサイズを指定せず、実装に最適なバッファーサイズを選択させる事が推奨されます。もしこのパラメーターの値が上に示した許された2の累乗の値でない場合、IndexSizeError例外を発生します ( MUST )。numberOfInputChannelsunsigned long ✘ ✔ このパラメーターはこのノードの入力チャンネル数を指定します。32 チャンネルまでの値がサポートされなくてはなりません。チャンネル数がサポート外の場合、 NotSupportedError例外を発生します。numberOfOutputChannelsunsigned long ✘ ✔ このパラメーターはこのノードの出力チャンネル数を指定します。32 チャンネルまでの値がサポートされなくてはなりません。チャンネル数がサポート外の場合、 NotSupportedError例外を発生します。戻り値:ScriptProcessorNode createStereoPanner()-

StereoPannerNodeの ファクトリーメソッド です。パラメーターなし戻り値:StereoPannerNode createWaveShaper()-

非線形な歪み効果を表す

WaveShaperNodeの ファクトリーメソッド です。パラメーターなし戻り値:WaveShaperNode decodeAudioData(audioData, successCallback, errorCallback)-

ArrayBuffer内にあるオーディオファイルのデータを非同期にデコードします。ArrayBufferは、例えばXMLHttpRequestでresponseTypeに"arraybuffer"を指定した場合のresponse属性としてロードされます。オーディオファイルデータはaudio要素でサポートされるどのフォーマットでも構いません。decodeAudioData()に渡されるバッファーは [mimesniff] で説明される手順で判定されるコンテントタイプを持ちます。この関数の基本的なインターフェイスの手段は戻り値の promise ではありますが、歴史的な理由からコールバックのパラメーターも提供されています。システムは Promise がリゾルブまたはリジェクトし、コールバック関数が呼ばれて完了する前に

AudioContextがガベージコレクションされない事を保証しなくてはなりません。decodeAudioDataが呼ばれたとき、制御スレッド上では次の手順を実行します ( MUST ):-

promise を新しい promise とします。

-

もし

audioDataに対する、IsDetachedBuffer([ECMASCRIPT] で説明されています) がfalseの場合、次の手順を実行します:-

audioDataArrayBufferを Detach します。この操作は [ECMASCRIPT] で説明されています。 -

別のスレッドで実行されるデコード処理をキューにいれます。

-

-

そうでなければ、次の手順を実行します:

-

error を

DataCloneErrorとします。 -

promise を error でリジェクトします。

-

errorCallbackを error で呼び出すタスクをキューに入れます。

-

-

promise を返します。

制御スレッド でも レンダリングスレッド でもない、デコーディングスレッドと呼ばれる別スレッドで実行されるデコード処理がキューに入れられるとき、次の手順が発生します ( MUST )。注 : 複数回の

decodeAudioDataの呼び出しを処理するため、複数のデコーディングスレッドが並列して走る事もあります。-

エンコードされている

audioDataをリニア PCM にデコードを試みます。 -

もしオーディオフォーマットが認識できない、サポートされていない、あるいはデータが破壊 / 不正 / 一貫していないという理由でデコードエラーが発生した場合、制御スレッド で次の手順を実行するためのタスクをキューに入れます:

-

error を

EncodingErrorという名前のDOMExceptionとします。 -

promise を error を持ってリジェクトします。

-

もし

errorCallbackがあれば、error を持ってerrorCallbackを呼び出します。

-

-

それ以外の場合:

-

リニア PCM で表現され、もし

audioDataのサンプルレートがAudioContextのサンプルレートと異なっていた場合はリサンプルを行ったものを結果とします。 -

制御スレッド のイベントループで次の手順を実行するタスクをキューに入れます:

buffer を最終的な結果 ( 必要ならサンプルレート変換を行った後 ) を保持した

AudioBufferとします。-

promise を buffer を持ってリゾルブします。

-

もし

successCallbackがあれば、buffer を持ってsuccessCallbackを呼び出します。

-

-

BaseAudioContext.decodeAudioData() メソッドの引数 パラメーター 型 Null可 省略可 説明 audioDataArrayBuffer ✘ ✘ 圧縮されたオーディオデータを含む ArrayBuffer です。 successCallbackDecodeSuccessCallback? ✔ ✔ デコードが完了したときに呼び出されるコールバック関数です。コールバック関数の引数は 1 つでデコードされた PCM オーディオデータをあらわす AudioBuffer になります。 errorCallbackDecodeErrorCallback? ✔ ✔ オーディオファイルをデコード中にエラーが起こった場合に呼び出されるコールバック関数です。 戻り値:Promise<AudioBuffer> -

resume()-

BaseAudioContextがサスペンドされている場合、currentTimeの進行を再開します。resume が呼ばれた場合、以下の手順が実行されます:-

promise を新しい Promise とします。

-

もし

BaseAudioContextの制御スレッドの状態フラグがclosedならば、promise をInvalidStateErrorでリジェクトし、以降の手順を中止して promise を返します。 -

もし

BaseAudioContextが スタート可能 ではないとき、promise を pendingResumePromises に追加して以降の手順を中止し、promise を返します。 -

BaseAudioContextの制御スレッドの状態フラグをrunningにします。 -

promise を返します。

BaseAudioContextを再開する 制御メッセージ を実行する事は レンダリングスレッド で、以下の手順を実行する事を意味します:-

システムリソースの取得 を試みます。

-

BaseAudioContext上の レンダリングスレッド状態 フラグをrunningにセットします。 -

オーディオグラフのレンダリング を開始します。

-

失敗した場合、制御スレッド に以下を実行するタスクをキューに入れ、これらの手順を中止します:

-

pendingResumePromises にあるすべての promise を順序に従ってリジェクトし、pendingResumePromises をクリアします。

-

promise をリジェクトします。

-

-

制御スレッド のイベントループで以下の手順を実行するタスクをキューに入れます:

-

pendingResumePromises にある promise を順序に従ってリゾルブし、pendingResumePromises をクリアします。

-

promise をリゾルブします。

-

もし

BaseAudioContextのstate属性が既に "running" でない場合:-

BaseAudioContextのstate属性を "running" にセットします。 -

BaseAudioContextにstatechangeという名前のシンプルイベントを発行するタスクをキューに入れます。

-

-

パラメーターなし -

1.1.3. コールバック DecodeSuccessCallback() パラメーター

decodedData,AudioBuffer 型-

デコードされたオーディオデータを保持する AudioBuffer です。

1.1.4. コールバック DecodeErrorCallback() パラメーター

error,DOMException 型-

デコード中に発生したエラーです。

1.1.5. ライフタイム

AudioContext は一度作成された後、これ以上再生する音がなくなるまで、あるいはページを移動するまで再生を続けます。

1.1.6. 内部検査やシリアライゼーションの基本機能の欠如

Web Audio API は音源のスケジューリングに fire-and-forget アプローチを取っています。つまり、音源ノード は、AudioContext のライフタイムの間のひとつひとつの音に対応して作成され、明示的にグラフからの削除は行いません。これはシリアライゼーション API とは互換性がなく、そのためシリアライズ可能な固定的なノードのセットもありません。

さらに、内部検査のための API を持つためにはスクリプトの中身のガベージコレクションの監視が必要になります。

1.1.7. BaseAudioContext のサブクラスに関連付けられるシステムリソース

サブクラス、AudioContext と OfflineAudioContext はコストの高いオブジェクトと考えるべきです。これらのオブジェクトの作成には、高プライオリティのスレッドまたは低レイテンシーのシステムオーディオを含み、どちらも消費電力への影響があります。通常は、1 つのドキュメント内に 1 つ以上の AudioContext を作成する事は不必要です。

BaseAudioContext のサブクラスの作成または再開は、そのコンテキストがシステムリソースを取得する事を含みます。このためには AudioContext としてはシステムオーディオのストリームを作成する事も必要です。これらの動作はコンテキストが関連するオーディオグラフから出力の生成を開始する際に処理を戻します。

なお、ユーザーエージェントは実装で定められた最大数の AudioContext を持つ事ができ、それ以上の新しい AudioContext の作成は失敗して、NotSupportedError 例外を発生します。

プログラマーは suspend および close を使う事で、スレッド、プロセスおよびオーディオストリームを含むシステムリソースの解放を行う事ができます。BaseAudioContext をサスペンドする事で、実装は一部のリソースを解放して後で resume を呼び出したときに再開できるようにします。 AudioContext のクローズによって、実装はすべてのリソースを解放し、再度使用したり再開したりはできなくなります。

注 : これは例えば、定期的なコールバックの呼び出しを待つ事やハードウェアが処理可能になるのを待つ事も含みます。

1.2. AudioContext インターフェイス

このインターフェイスは、その AudioDestinationNode がデバイスへのリアルタイム出力によって直接ユーザーに信号が届くオーディオグラフを表します。多くの場合、1 つのドキュメントにつき 1 つの AudioContext が使用されます。

もしユーザーエージェントとシステムが現在のコンテキストでオーディオの出力を許可していれば、AudioContext はスタート可能となります。言い換えれば、 AudioContext の制御スレッドの状態は suspended から running に遷移する事ができます。

注 : 例えば、ユーザーエージェントとしては AudioContext の制御スレッドが状態を running に変えるには ( [HTML] で説明されている ) ユーザーアクションによるトリガー が必要かもしれません。

enum {AudioContextLatencyCategory "balanced" ,"interactive" ,"playback" };

| 列挙値の説明 | |

|---|---|

"balanced"

| オーディオ出力のレイテンシーと安定性/消費電力のバランスを取ります。 |

"interactive"

| オーディオ出力のレイテンシーをグリッジが発生しない最小値にする。これがデフォルトになります。 |

"playback"

| オーディオ出力のレイテンシーよりも再生の途切れを起こさない事を優先します。消費電力は最も低くなります。 |

[Exposed =Window ,Constructor (optional AudioContextOptions )]contextOptions interface :AudioContext BaseAudioContext {readonly attribute double baseLatency ;readonly attribute double outputLatency ;AudioTimestamp getOutputTimestamp ();Promise <void >suspend ();Promise <void >close ();MediaElementAudioSourceNode createMediaElementSource (HTMLMediaElement );mediaElement MediaStreamAudioSourceNode createMediaStreamSource (MediaStream );mediaStream MediaStreamTrackAudioSourceNode createMediaStreamTrackSource (MediaStreamTrack );mediaStreamTrack MediaStreamAudioDestinationNode createMediaStreamDestination (); };

1.2.1. コンストラクタ

AudioContext(contextOptions)-

AudioContextを作成する際は、以下の手順を実行します:-

AudioContext上の制御スレッドの状態をsuspendedにセットします。 -

AudioContext上のレンダリングスレッドの状態をsuspendedにセットします。 -

pendingResumePromises を空の promise のリストとします。

-

もし

contextOptionsが与えられていれば、オプションを適用します:-

この

AudioContextの内部レイテンシーをlatencyHintの項に書かれているように、contextOptions.に従ってセットします。latencyHint -

もし

contextOptions.が指定されていれば、このsampleRateAudioContextのsampleRateをその値にセットします。 そうでなければ、デフォルト出力デバイスのサンプルレートを使用します。 もし選択されたサンプルレートが出力デバイスのサンプルレートと異なる場合、このAudioContextはオーディオ出力を出力デバイスのサンプルレートに合うようにリサンプリングしなくてはなりません ( MUST )。注 : もしリサンプリングが必要とされる場合、AudioContext のレイテンシーに大きな影響があるかも知れません。

-

-

もし

AudioContextが スタート可能 でない場合、これらの手順は中止されます。 -

処理を開始するための 制御メッセージ を送ります。

処理を開始するための 制御メッセージ を送るには次の手順を実行します:-

システムリソースの取得 を試みます。

-

失敗した場合、これらの手順を中止します。

-

AudioContextの レンダリングスレッドの状態 をrunningにセットします。 -

制御スレッド のイベントループで以下の手順を実行するためのタスクをキューに入れます:

-

AudioContextのstate属性を "running" にセットします。 -

AudioContextにstatechangeという名前のシンプルイベントを発行するためのタスクをキューに入れます。

-

注 : 残念ながら、

AudioContextの作成の失敗についてプログラム上の通知をすることはできません。ユーザーエージェントは、デベロッパーツールコンソールのようなログメカニズムにアクセスできる場合、これを知らせるメッセージをログに記録することをお勧めします。AudioContext.AudioContext() メソッドの引数 パラメーター 型 Null可 省略可 説明 contextOptionsAudioContextOptions ✘ ✔ AudioContextをどのように作成するかをユーザーが指定するオプション。 -

1.2.2. 属性

baseLatency, double 型, readonly-

これは

AudioContextがAudioDestinationNodeからオーディオサブシステムにオーディオを渡す処理で発生するレイテンシーの秒数を表します。これにはAudioDestinationNodeの出力とオーディオハードウェアの間で発生するかも知れないその他の処理による追加のレイテンシーは含まれず、特にオーディオグラフ自体に発生するレイテンシーは含まれません。例えばもし、オーディオコンテキストが 44.1 kHz で動作しており、

AudioDestinationNodeの実装が内部でダブルバッファリングによる レンダリング量子 の出力処理を行う場合、処理のレイテンシーは、約 \((2\cdot128)/44100 = 5.805 \mathrm{ ms}\) となります。 outputLatency, double 型, readonly-

オーディオ出力処理のレイテンシーの秒数の見積もり。つまり、UA がホストシステムにバッファーを再生を要求した時間から、バッファー内の最初のサンプルが実際にオーディオ出力デバイスで処理される時間までの間隔。この後者の時間は、スピーカーやヘッドフォンのような音の信号を発生するデバイスがサンプルの音を発生する時間を指します。

outputLatency属性の値はプラットフォームと接続されているオーディオ出力デバイスに依存します。outputLatency属性の値は接続されているオーディオ出力デバイスが同じである限り、コンテキストのライフタイムを通じて変化する事はありません。もしオーディオ出力デバイスが変化したならば、outputLatency属性の値もそれに従ってアップデートされます。

1.2.3. メソッド

close()-

AudioContextをクローズし、使用中の システムリソースを解放 します。これは、AudioContextが作成したすべてのオブジェクトを自動的に開放はしませんが、AudioContextのcurrentTimeの進行を止め、オーディオデータの処理を停止します。close が呼ばれたとき、以下の手順が実行されます:-

promise を新しい Promise とします。

-

もし

AudioContextの制御スレッドの状態フラグがclosedであった場合、promise をInvalidStateErrorでリジェクトし、これらの手順を中断して promise を返します。 -

もし

AudioContextのstate属性が既に "closed" であった場合、promise をリゾルブして返却し、これらの手順を中断します。 -

AudioContextの制御スレッドの状態フラグをclosedにセットします。 -

promise を返します。

AudioContextをクローズするための 制御メッセージ を実行する事は、レンダリングスレッド で、以下の手順を実行する事を意味します:-

システムリソースの解放 を試みます。

-

レンダリングスレッドの状態 を

suspendedにセットします。 -

制御スレッド のイベントループで以下の手順を実行するタスクをキューに入れます:

-

promise をリゾルブします。

-

もし

AudioContextのstate属性が既に "closed" でない場合:-

AudioContextのstate属性を "closed" にセットします。 -

AudioContextでstatechangeという名前のシンプルイベントを発行するためのタスクをキューに入れます。

-

-

AudioContextがクローズされた場合、AudioContextに接続されているすべての MediaStream とHTMLMediaElementはその出力を無視されます。 つまり、これらはもうスピーカーなどの出力デバイスに出力されなくなります。より柔軟な挙動のためには、HTMLMediaElement.captureStream()の使用を検討してください。注 :

AudioContextがクローズされるとき、実装はサスペンドの場合よりも積極的に多くのリソースを解放する事ができます。パラメーターなし -

createMediaElementSource(mediaElement)-

指定された HTMLMediaElement から

MediaElementAudioSourceNodeを作成します。 このメソッドの呼び出しにより、HTMLMediaElement からのオーディオの再生はAudioContextの処理グラフに再ルーティングされるようになります。AudioContext.createMediaElementSource() メソッドの引数 パラメーター 型 Null可 省略可 説明 mediaElementHTMLMediaElement ✘ ✘ 再ルーティングされるメディアエレメントです。 createMediaStreamDestination()-

MediaStreamAudioDestinationNodeを作成します。パラメーターなし createMediaStreamSource(mediaStream)-

MediaStreamAudioSourceNodeを作成します。AudioContext.createMediaStreamSource() メソッドの引数 パラメーター 型 Null可 省略可 説明 mediaStreamMediaStream ✘ ✘ 音源となるメディアストリームです。 createMediaStreamTrackSource(mediaStreamTrack)-

MediaStreamTrackAudioSourceNodeを作成します。AudioContext.createMediaStreamTrackSource() メソッドの引数 パラメーター 型 Null可 省略可 説明 mediaStreamTrackMediaStreamTrack ✘ ✘ 音源となる MediaStreamTrack です。 その kind属性は"audio"でなくてはならず、そうでない場合は、InvalidStateError例外を発生します ( MUST )。 getOutputTimestamp()-

コンテキストのオーディオストリームについて、2 つの関連する位置情報を含む新しい

AudioTimestampインスタンスを返します:contextTimeメンバーには、オーディオ出力デバイスによって現在レンダリングされているサンプルフレームの時間 ( つまり出力されているオーディオストリームの位置 ) が含まれます。これにはコンテキストのcurrentTimeと同じ単位と起点を使用します。 そしてperformanceTimeメンバーには、contextTimeに格納された値に対応するサンプルフレームがperformance.now()( [hr-time-2] で説明されています ) と同じ単位および起点で、オーディオ出力デバイスによってレンダリングされる瞬間を推定する時間が含まれます 。コンテキストのレンダリンググラフがまだオーディオブロックを処理していないときに

getOutputTimestampを呼び出すと、両方のメンバーが 0 であるAudioTimestampインスタンスを返します。コンテキストのレンダリンググラフがオーディオブロックの処理を開始すると、その

currentTime属性の値は常にgetOutputTimestampメソッドの呼び出しで取得されるcontextTime値より大きくなります。getOutputTimestampメソッドから返された値は、コンテキストの時刻のわずかに後になるパフォーマンスの時刻の見積もりを得るのに使用できます:function outputPerformanceTime( contextTime) { var timestamp= context. getOutputTimestamp(); var elapsedTime= contextTime- timestamp. contextTime; return timestamp. performanceTime+ elapsedTime* 1000 ; } 上の例での見積もりの精度は、引数の値が現在の出力オーディオストリームの位置にどれほど近いかによって決まります: つまり与えられた

contextTimeがtimestamp.contextTimeに近いほど、得られた推定の精度は良くなります。注 : コンテキストの

currentTimeとgetOutputTimestampメソッドの呼び出しから得られたcontextTimeの値の差は、currentTimeが不均一な時間間隔で増加する可能性があるため、信頼できる出力レイテンシーの見積もりとみなす事はできず、代わりにoutputLatency属性を使用する必要があります。パラメーターなし戻り値:AudioTimestamp suspend()-

AudioContextのcurrentTimeの進行を中断し、デスティネーションで再生するために既に処理を終えた現在のコンテキストの処理ブロックを再生し、その後システムがオーディオハードウェアの占有を解放できるようにします。 これは一般的に、アプリケーションがしばらくの間AudioContextを必要とせず、一時的にAudioContextに関連付けられた システムリソースを解放 したいことがアプリケーションに分かっているときに役に立ちます。この promise は、フレームバッファーが空のとき ( ハードウェアに渡されたとき )、またはコンテキストがすでにsuspended状態のときは即座に ( 副作用なしで ) リゾルブされます。コンテキストがクローズされた場合、promise はリジェクトされます。suspend が呼び出された場合、以下の手順を実行します:-

promise を新しい Promise とします。

-

もし

AudioContextの制御スレッドの状態フラグがclosedの場合、promise をInvalidStateErrorでリジェクトし、これらの手順を中止して promise を返します。 -

AudioContextの制御スレッドの状態フラグをsuspendedにセットします。 -

AudioContextをサスペンドするための制御メッセージをキューに入れます。 -

promise を返します。

AudioContextをサスペンドするための 制御メッセージ を実行する、とは レンダリングスレッド で、以下の手順を実行する事を意味します:-

システムリソースの解放 を試みます。

-

AudioContextの レンダリングスレッドの状態 をsuspendedにセットします。 -

制御スレッド のイベントループで以下の手順を実行するタスクをキューに入れます:

-

promise をリゾルブします。

-

もし

AudioContextのstate属性が既に "suspended" でない場合:-

AudioContextのstate属性を "suspended" にセットします。 -

AudioContextでstatechangeという名前のシンプルイベントを発行するタスクをキューに入れます。

-

-

AudioContextがサスペンドされている間、MediaStream の出力は無視されます。つまり、メディアストリームのリアルタイム性によって、データは失われます。HTMLMediaElementも同様に、システムが再開されるまでその出力は無視されます。AudioWorkletNodeおよびScriptProcessorNodeは、サスペンド中は処理ハンドラーの呼び出しが止まりますが、コンテキストがリジュームされると再開します。AnalyserNodeでは、ウィンドウ関数の目的そのものにより、データは連続ストリームとみなされます。つまり、resume()/suspend()によってAnalyserNodeのデータストリームに無音は発生しません。特に、AudioContextがサスペンドされているときにAnalyserNodeの関数を繰り返し呼び出した際は、同じデータが返されなければなりません ( MUST )。パラメーターなし -

1.2.4. AudioContextOptions

AudioContextOptions ディクショナリは AudioContext のユーザー指定のオプションを決めるために使用されます。

dictionary { (AudioContextOptions AudioContextLatencyCategory or double )latencyHint = "interactive";float sampleRate ; };

1.2.4.1. ディクショナリ AudioContextOptions メンバー

latencyHint,(AudioContextLatencyCategory または double)型, デフォルトは"interactive"-

オーディオ出力のレイテンシーと消費電力の間のトレードオフに影響を与える、再生のタイプを指示します。

latencyHintの値は、AudioContextLatencyCategoryから選択する事が推奨されます。ただし、レイテンシーと消費電力をより細かくバランスを取るために、レイテンシーの秒数を double 型で指定することもできます。数値を適切に解釈するのはブラウザーの裁量に委ねられています。実際に使用されるレイテンシーは、AudioContext のbaseLatency属性によって与えられます。 sampleRate, float 型-

作成される

AudioContextのsampleRateをこの値に設定します。サポートされている値は、AudioBufferのサンプルレートと同じです。指定されたサンプルレートがサポートされていない場合は、NotSupportedError例外を発生します ( MUST )。もし

sampleRateが指定されていない場合、このAudioContextの出力デバイスが推奨するサンプルレートが使用されます。

1.2.5. AudioTimestamp

dictionary {AudioTimestamp double contextTime ;DOMHighResTimeStamp performanceTime ; };

1.2.5.1. ディクショナリ AudioTimestamp メンバー

contextTime, double 型-

BaseAudioContext の

currentTimeの時間軸内の時刻を表します。 performanceTime, DOMHighResTimeStamp 型-

Performanceインターフェイスの実装における時間軸内の時刻を表します ( [hr-time-2] で説明されています )。

1.3. OfflineAudioContext インターフェイス

OfflineAudioContext は、レンダリング/ミックスダウンのための特殊なタイプの BaseAudioContext で、( 潜在的には ) リアルタイムよりも高速に動作します。これはオーディオハードウェアに対してレンダリングせず、返した promise に可能な限り高速にレンダリングした結果を AudioBuffer として渡します。

[Exposed =Window ,Constructor (OfflineAudioContextOptions contextOptions ),Constructor (unsigned long numberOfChannels ,unsigned long length ,float sampleRate )]interface :OfflineAudioContext BaseAudioContext {Promise <AudioBuffer >startRendering ();Promise <void >suspend (double );suspendTime readonly attribute unsigned long length ;attribute EventHandler oncomplete ; };

1.3.1. コンストラクタ

OfflineAudioContext(contextOptions)-

c を新しい

OfflineAudioContextオブジェクトとします。c を次のように初期化します:-

c の

制御スレッドの状態を "suspended" とします。 -

c の

制御スレッドの状態を"suspended"とします。 -

channelCountをcontextOptions.numberOfChannelsとしたAudioDestinationNodeを作成します。

OfflineAudioContext.OfflineAudioContext(contextOptions) メソッドの引数 パラメーター 型 Null可 省略可 説明 contextOptionsこのコンテキストを作成する際に必要な初期化パラメーター -

OfflineAudioContext(numberOfChannels, length, sampleRate)-

OfflineAudioContextは AudioContext.createBuffer と同じ引数で作成できます。もし引数のどれかが負、0、または範囲外の場合はNotSupportedError例外を発生します ( MUST )。OfflineAudioContext は、次の呼び出し

new OfflineAudioContext({ numberOfChannels: numberOfChannels, length: length, sampleRate: sampleRate}) が行われたのと同じように作成されます。

OfflineAudioContext.OfflineAudioContext(numberOfChannels, length, sampleRate) メソッドの引数 パラメーター 型 Null可 省略可 説明 numberOfChannelsunsigned long ✘ ✘ バッファーが持つチャンネルの数を指定します。サポートされているチャンネル数については、 createBuffer()を参照してください。lengthunsigned long ✘ ✘ バッファーのサイズをサンプルフレーム数で指定します。 sampleRatefloat ✘ ✘ バッファー内のリニア PCM オーディオデータのサンプルレートをサンプルフレーム / 秒で記述します。有効なサンプルレートについては、 createBuffer()を参照してください。

1.3.2. 属性

length, unsigned long 型, readonly-

サンプルフレーム数で表したバッファーのサイズ。これは、コンストラクタの

lengthパラメーターの値と同じです。 oncomplete, EventHandler 型-

OfflineAudioCompletionEvent. 型の EventHandler です。これは、

OfflineAudioContextで最後に発行されるイベントです。

1.3.3. メソッド

startRendering()-

現在の接続と変化のスケジュールが与えられると、オーディオのレンダリングが開始されます。システムは promise を リゾルブし、コールバック関数が呼び出されて完了するか、

suspend関数が呼び出されるまで、OfflineAudioContextがガベージコレクションされないようにしなければなりません。レンダリングされたオーディオデータを取得する主な方法は、promise の戻り値を経由する方法ですが、インスタンスは歴史的な理由により、

completeという名前のイベントも発生させます。[[rendering started]]をこのOfflineAudioContextの内部スロットとします。 このスロットは false に初期化されます。startRenderingが呼び出されたとき、制御スレッド で次の手順を実行しなくてはなりません ( MUST )。-

OfflineAudioContextの[[rendering started]]スロットが true の場合、InvalidStateErrorでリジェクトした promise を返し、これらの手順を中止します。 -

OfflineAudioContextの[[rendering started]]スロットを true に設定します。 - promise を新しい Promise とします。

-

contextOptionsパラメーターでこのインスタンスのコンストラクタに渡されたnumberOfChannels、length、およびsampleRateの値にそれぞれ等しいチャンネル数、長さ、およびサンプルレートを持つ、新しいAudioBufferを作成します。このバッファーをOfflineAudioContextの内部スロット[[rendered buffer]]に割り当てます。 -

前項の

AudioBufferコンストラクタ呼び出し中に例外が発生した場合、この例外を持って promise をリジェクトします。 - そうでなく、バッファーが正常に作成された場合は、オフラインレンダリングを開始 します。

- promise を返します。

オフラインレンダリングを開始するには、その際に作成された レンダリングスレッド で次の手順が実行されなくてはなりません ( MUST )。-

現在の接続と変化のスケジュールが与えられたら、

length長のオーディオのサンプルフレームを[[rendered buffer]]にレンダリングし始めます。 - レンダリング量子 ごとに、チェックを行い、必要ならばサスペンドします。

- もしサスペンドされていたコンテキストが再開された場合、バッファーへのレンダリングを継続します。

-

レンダリングが完了したら、制御スレッド のイベントループで次の手順を実行するタスクをキューに入れます:

-

startRendering()によって作成された promise を[[rendered buffer]]をもってリゾルブします。 -

OfflineAudioCompletionEventのインスタンスのrenderedBufferプロパティに[[rendered buffer]]を設定し、completeという名前のイベントを発行するタスクをキューに入れます。

-

パラメーターなし戻り値:Promise<AudioBuffer> -

suspend(suspendTime)-

指定された時刻にオーディオコンテキストの時間進行の停止をスケジュールし、promise を返します。これは一般的に、

OfflineAudioContextでオーディオグラフを同期して操作する場合に有用です。サスペンドの最大の精度は レンダリング量子 のサイズであり、指定されたサスペンドの時刻は最も近い レンダリング量子 の境界に丸められることに注意してください。このため、同じ量子化されたフレーム内で複数のサスペンドをスケジュールすることはできません。また、精度の高いサスペンドを確実に行うには、コンテキストが running でない間にスケジューリングを行う必要があります。

OfflineAudioContext.suspend() メソッドの引数 パラメーター 型 Null可 省略可 説明 suspendTimedouble ✘ ✘ 指定された時刻にレンダリングのサスペンドをスケジューリングします。時刻は レンダリング量子 のサイズで量子化されて丸められます。 量子化されたフレーム番号が - 負の値

- 現在の時刻より小さいか同じ

- レンダリング全体の長さより大きいか同じ

- 同じ時刻に別のサスペンドがスケジュールされている

InvalidStateErrorでリジェクトされます。

1.3.4. OfflineAudioContextOptions

これは、OfflineAudioContext の作成の際に使用するオプションを指定します。

dictionary {OfflineAudioContextOptions unsigned long numberOfChannels = 1;required unsigned long length ;required float sampleRate ; };

1.3.4.1. ディクショナリ OfflineAudioContextOptions メンバー

length, unsigned long 型-

サンプルフレーム数で表したレンダリングされる

AudioBufferの長さ。 numberOfChannels, unsigned long 型, デフォルトは1-

この

OfflineAudioContextのチャンネル数。 sampleRate, float 型-

この

OfflineAudioContextのサンプルレート。

1.3.5. OfflineAudioCompletionEvent インターフェイス

これは、歴史的な理由から OfflineAudioContext に発行される Event オブジェクトです。

[Exposed =Window ,(Constructor DOMString ,type OfflineAudioCompletionEventInit )]eventInitDict interface :OfflineAudioCompletionEvent Event {readonly attribute AudioBuffer renderedBuffer ; };

1.3.5.1. 属性

renderedBuffer, AudioBuffer 型, readonly-

レンダリングされたオーディオデータを含む

AudioBufferです。

1.3.5.2. OfflineAudioCompletionEventInit

dictionary :OfflineAudioCompletionEventInit EventInit {required AudioBuffer renderedBuffer ; };

1.3.5.2.1. ディクショナリ OfflineAudioCompletionEventInit メンバー

renderedBuffer, AudioBuffer 型-

イベントの

renderedBuffer属性に割り当てる値。

1.4. AudioBuffer インターフェイス

このインターフェイスは、メモリー上にあるオーディオデータ ( ワンショットサウンドおよびその他の短いオーディオクリップ用 ) を表します。そのフォーマットはノンインタリーブな 32 ビットの浮動小数点の リニア PCM で、通常は \([−1, 1]\) の範囲になりますが、値はこの範囲に限定はされません。これは 1 つまたは複数のチャンネルを持つことができます。通常、PCM データの長さはかなり短く ( 通常は 1 分未満 ) と想定されています。音楽サウンドトラックなどのより長いサウンドの場合、audio 要素と MediaElementAudioSourceNode によるストリーミングを使うべきです。

AudioBuffer は、1 つ以上の AudioContext によって使用される事があり、OfflineAudioContext と AudioContext の間で共有する事もできます。

AudioBuffer には 4 つの内部スロットがあります:

[[number of channels]]-

この

AudioBufferのオーディオチャンネルの数、符号なし long 型です。 [[length]]-

この

AudioBufferの各チャンネルの長さ、符号なし long 型です。 [[sample rate]]-

Hz で表した

AudioBufferのサンプルレート、float 型です。 [[internal data]]-

オーディオのサンプルデータを保持する データブロック です。

[Exposed =Window ,Constructor (AudioBufferOptions )]options interface {AudioBuffer readonly attribute float sampleRate ;readonly attribute unsigned long length ;readonly attribute double duration ;readonly attribute unsigned long numberOfChannels ;Float32Array getChannelData (unsigned long );channel void copyFromChannel (Float32Array ,destination unsigned long ,channelNumber optional unsigned long = 0);startInChannel void copyToChannel (Float32Array ,source unsigned long ,channelNumber optional unsigned long = 0); };startInChannel

1.4.1. コンストラクタ

AudioBuffer(options)-

-

optionsの値のいずれかが公称範囲外にある場合は、NotSupportedError例外を発生し、以下の手順を中止します。 -

b を新しい

AudioBufferオブジェクトとします。 -

コンストラクタで渡された AudioBufferOptions の属性

numberOfChannels、length、sampleRateの値をそれぞれ内部スロット[[number of channels]]、[[length]]、[[sample rate]]に割り当てます。 -

この

AudioBufferの内部スロット[[internal data]]をCreateByteDataBlock(を呼び出した結果に設定します。[[length]]*[[number of channels]])注 : これは、下層にある記憶域をゼロに初期化します。

-

b を返します。

AudioBuffer.AudioBuffer() メソッドの引数 パラメーター 型 Null可 省略可 説明 optionsAudioBufferOptions ✘ ✘ -

1.4.2. 属性

duration, double 型, readonly-

PCM オーディオデータの長さで、単位は秒です。

これは

[[sample rate]]とAudioBufferの[[length]]から計算され、[[length]]を[[sample rate]]で割る事で求められます。 length, unsigned long 型, readonly-

サンプルフレーム数で表した PCM オーディオデータの長さです。これは

[[length]]の値を返さなければなりません ( MUST )。 numberOfChannels, unsigned long 型, readonly-

個別のオーディオチャンネルの数です。これは

[[number of channels]]の値を返さなければなりません ( MUST )。 sampleRate, float 型, readonly-

サンプル / 秒で表した PCM オーディオデータのサンプルレートです。これは、

[[sample rate]]の値を返さなければなりません ( MUST )。

1.4.3. メソッド

copyFromChannel(destination, channelNumber, startInChannel)-

copyFromChannel()メソッドは、AudioBufferの指定されたチャンネルからサンプルをdestinationの配列にコピーします。bufferを \(N_b\) フレームのAudioBufferとし、\(N_f\) をdestination配列の要素数とし、\(k\) をstartInChannelの値とします。このとき、bufferからdestinationにコピーされるフレームの数は \(\min(N_b - k, N_f)\) となります。もしこれが \(N_f\) より小さい場合、destinationの残りの要素は変更されません。AudioBuffer.copyFromChannel() メソッドの引数 パラメーター 型 Null可 省略可 説明 destinationFloat32Array ✘ ✘ チャンネルデータがコピーされる配列です。 channelNumberunsigned long ✘ ✘ データをコピーするチャンネルのインデックスです。 channelNumberがAudioBufferのチャンネル数と同じか大きい場合、IndexSizeError例外を発生します ( MUST )。startInChannelunsigned long ✘ ✔ データをどこからコピーするかのオプションのオフセットです。 startInChannelがAudioBufferのlengthより大きい場合は、IndexSizeError例外を発生します ( MUST )。戻り値:void copyToChannel(source, channelNumber, startInChannel)-

copyToChannel()メソッドは、source配列からAudioBufferの指定されたチャンネルにサンプルをコピーします。もし、

sourceがバッファーにコピーできない場合は、UnknownErrorを発生します。bufferを \(N_b\) フレームのAudioBufferとし、\(N_f\) をsource配列の要素数とし、\(k\) をstartInChannelの値とします。このとき、sourceからbufferにコピーされるフレームの数は \(\min(N_b - k, N_f)\) となります。これが \(N_f\) より小さい場合、bufferの残りの要素は変更されません。AudioBuffer.copyToChannel() メソッドの引数 パラメーター 型 Null可 省略可 説明 sourceFloat32Array ✘ ✘ チャンネルデータがコピーされる元の配列です。 channelNumberunsigned long ✘ ✘ データをコピーする先のチャンネルのインデックスです。 channelNumberがAudioBufferのチャンネル数より大きいか同じ場合、IndexSizeErrorを発生します ( MUST )。startInChannelunsigned long ✘ ✔ データをコピーする先を示すオプションのオフセットです。 startInChannelがAudioBufferのlengthより大きい場合は、IndexSizeError例外を発生します ( MUST )。戻り値:void getChannelData(channel)-

コンテントの取得 の 参照の取得 または コピーの取得 で説明されているルールに従って、

[[internal data]]に格納されているバイトデータを新しいFloat32Arrayとして取得します。もし、

[[internal data]]の読み出しまたはFloat32Arrayが作成できなかった場合は、UnknownErrorを発生します。AudioBuffer.getChannelData() メソッドの引数 パラメーター 型 Null可 省略可 説明 channelunsigned long ✘ ✘ このパラメーターは、データを取得する特定のチャンネルを表すインデックスです。インデックス値 0 は最初のチャンネルを表します。このインデックス値は numberOfChannelsより小さくなくてはならず ( MUST )、そうでない場合はIndexSizeError例外を発生します ( MUST )。戻り値:Float32Array

注 : copyToChannel() および copyFromChannel() メソッドは、より大きな配列に対する view である Float32Array を渡す事で配列の一部だけを埋める事ができます。AudioBuffer のチャンネルからデータのブロックを読み出す場合、getChannelData() を呼び出して結果の配列にアクセスするよりも不必要なメモリー割り当てとコピーを避けるため、copyFromChannel() を使用するべきです。

APIの実装が AudioBuffer の内容が必要になったとき、「AudioBuffer の内容の取得」の内部処理が起動されます。この処理は呼び出し元に変更不能なチャンネルデータを返します。

AudioBuffer の 「内容の取得」 処理は次の手順で実行されます:

-

AudioBufferのArrayBufferのどれかがIsDetachedBufferに対してtrueを返した場合、これらの手順を中止し、呼び出し元に長さ 0 のチャンネルデータバッファーを返します。 -

この

AudioBufferのgetChannelData()によってこれまでに返された配列のすべてのArrayBufferを デタッチ します。 -

これらの

ArrayBufferの下層にある[[internal data]]を保持し、それらへの参照を呼び出し側に返します。 -

次回の

getChannelData()の呼び出しでは、AudioBufferのデータのコピーを保持するArrayBufferをアタッチして返します。

「AudioBuffer の内容の取得」 は、次の場合に呼び出されます:

-

AudioBufferSourceNode.startが呼び出されると、ノードのbufferの「内容の取得」を行います。この処理が失敗した場合、何も再生されません。 -

AudioBufferSourceNode.startがあらかじめ呼び出されている状態で、AudioBufferSourceNodeのbufferがセットされたとき、setter はAudioBufferの「内容の取得」を行います。この処理が失敗した場合、何も再生されません。 -

ノードが出力ノードに接続されている状態で

ConvolverNodeのbufferがあるAudioBufferに設定されたとき、またはConvolverNodeのbufferがあるAudioBufferに設定されている状態でConvolverNodeが出力ノードに接続されたときに、AudioBufferの「内容の取得」が行われます。 -

AudioProcessingEventのディスパッチが完了すると、そのoutputBufferの「内容の取得」が行われます。

注 : これは copyToChannel() は現在 AudioNode が「AudioBuffer の内容を取得」して使用している AudioBuffer の内容を変更するためには使えない事を意味します。AudioNode は以前に取得したデータを使い続けます。

1.4.4. AudioBufferOptions

これは、AudioBuffer の作成に使用するオプションを指定します。length と sampleRate メンバーは必須です。必須のメンバーが指定されていない場合は、NotFoundError 例外を発生します ( MUST )。

dictionary {AudioBufferOptions unsigned long numberOfChannels = 1;required unsigned long length ;required float sampleRate ; };

1.4.4.1. ディクショナリ AudioBufferOptions メンバー

このディクショナリのメンバーが取れる値には制約があります。createBuffer() を参照してください。

length, unsigned long 型-

サンプルフレーム数で表されるバッファーの長さです。制約については

lengthを参照してください。 numberOfChannels, unsigned long 型, デフォルトは1-

バッファーのチャンネル数です。制約については

numberOfChannelsを参照してください。 sampleRate, float 型-

Hz で表されるバッファーのサンプルレートです。制約については

sampleRateを参照してください。

1.5. AudioNode インターフェイス

AudioNode は、AudioContext を構成するブロックです。このインターフェイスは、オーディオソース、オーディオデスティネーション、および中間の処理モジュールを表しています。これらのモジュールは互いに接続されて、音をオーディオハードウェアに出力するための 処理グラフ を形成します。それぞれのノードは 入力 や 出力 を持つ事ができます。ソースノード は入力を持たず、単一の出力を持ちます。フィルターのようなほとんどの処理ノードは、1 つの入力と 1 つの出力を持ちます。それぞれのタイプの AudioNode はどのようにオーディオを処理したり合成するのかの詳細が異なっています。しかし一般的に、AudioNode は ( 持っていれば ) 入力を処理し、( 持っていれば ) その出力にオーディオ信号を送り出します。

それぞれの出力は 1 つ以上のチャンネルを持っています。正確なチャンネル数はそれぞれの AudioNode の詳細に依存します。

出力は 1 つ以上の AudioNode 入力に接続でき、つまりファンアウトがサポートされています。入力は初期化時には接続されていません。しかし、1 つ以上の AudioNode 出力から接続する事ができ、即ち、ファンインがサポートされています。AudioNode の出力を AudioNode の入力に接続するため connect() メソッドが呼ばれたとき、それをその入力への connection と呼びます。

各 AudioNode の入力はその時々で特定のチャンネル数を持ちます。この数はその入力への 接続 によって変化します。もし入力が接続を持っていない場合、チャンネル数は 1 で無音となります。

AudioNode は 各々の 入力 について、その入力へのすべての接続のミックス ( 通常はアップミックス ) を行います。この詳細に関して参考情報としては §3 ミキサーゲイン構成 、基準としての詳細要件については §5 チャンネルのアップミックスとダウンミックス セクションを参照してください。

AudioNode の入力および内部の処理は、そのノードが出力を接続されているか、またそれらの出力が AudioContext の AudioDestinationNode に最終的に到達しているかどうかに関わらず、AudioContext の時刻を踏まえて継続的に行われます。

パフォーマンス上の理由から、実際の実装では、ブロック処理を使用する必要があります。各 AudioNode は、block-size で示される大きさの固定の数のサンプルフレームを処理します。実装全体の振る舞いを統一するため、この値を明示的に定めます。block-size は、44.1kHz のサンプルレートで約 3ms に対応する 128 サンプルフレームと定義します。

[Exposed =Window ]interface AudioNode :EventTarget {AudioNode connect (AudioNode destinationNode ,optional unsigned long output = 0,optional unsigned long input = 0);void connect (AudioParam destinationParam ,optional unsigned long output = 0);void disconnect ();void disconnect (unsigned long output );void disconnect (AudioNode destinationNode );void disconnect (AudioNode destinationNode ,unsigned long output );void disconnect (AudioNode destinationNode ,unsigned long output ,unsigned long input );void disconnect (AudioParam destinationParam );void disconnect (AudioParam destinationParam ,unsigned long output );readonly attribute BaseAudioContext context ;readonly attribute unsigned long numberOfInputs ;readonly attribute unsigned long numberOfOutputs ;attribute unsigned long channelCount ;attribute ChannelCountMode channelCountMode ;attribute ChannelInterpretation channelInterpretation ; };

1.5.1. AudioNode の作成

AudioNode の作成には 2 つの方法があります: 特定のインターフェイスのコンストラクタを使用する方法、と BaseAudioContext または AudioContext の ファクトリーメソッドを使用する方法です。

AudioNode のコンストラクタの最初の引数として渡される BaseAudioContext は、作成される AudioNode が関連する BaseAudioContext と呼ばれます。同様に、ファクトリーメソッドを使用する場合、AudioNode が関連する BaseAudioContext は このファクトリーメソッドが呼び出される BaseAudioContext です。

BaseAudioContext c を最初の引数とし、関連するオプションオブジェクト option を 2 番目の引数として、特定の型 n の新しい AudioNode を c の 関連するグローバル から作成するには、次の手順を実行します:

-

o を型 n の新しいオブジェクトとします。

-

c および option を引数として o を 初期化 します。

-

o を返します。

AudioNode から継承したインターフェイス n のオブジェクト o を初期化する事は、このインターフェイスのコンストラクタに引数 context と dict を渡して、次のステップを実行することを意味します。

-

context を o が関連する

BaseAudioContextとします。 -

numberOfInputs、numberOfOutputs、channelCount、channelCountMode、channelInterpretationの値を、各AudioNodeのセクションで説明するそれぞれのインターフェイスのデフォルト値に設定します。 -

作成される

AudioNodeがConvolverNodeの場合、normalize属性を dict のdisableNormalizationの逆の値に設定し、buffer属性を dict メンバーのbufferの値に順次設定し、この手順の最後のステップにジャンプします。注 : これは、バッファーが

normalize属性の値に従って正規化されることを意味します。 -

渡された dict の各メンバーについて、k をメンバーのキー、v を値として、以下の手順を実行します:

-

k が

disableNormalizationまたはbufferで、n がConvolverNodeの場合、このループの先頭にジャンプします。 -

k がこのインターフェイスの

AudioParamの名前である場合、このAudioParamのvalue属性を v に設定します。 -

そうでなく、k がこのインターフェイスの属性の名前である場合、この属性に関連付けられたオブジェクトを v に設定します。

-

ファクトリーメソッドに関連するインターフェイスは、このメソッドから返されるオブジェクトのインターフェイスです。インターフェイスに関連するオプションオブジェクトは、このインターフェイスのコンストラクタに渡すことができるオプションオブジェクトです。

AudioNode は [DOM] で説明されているように EventTarget です。つまり、他の EventTargets がイベントを受け入れるのと同じ方法で、イベントを AudioNode にディスパッチすることができます。

enum {ChannelCountMode "max" ,"clamped-max" ,"explicit" };

ChannelCountMode は、ノードの channelCount および channelInterpretation の値と組み合わせて、ノードへの入力をどのようにミックスするかを制御する computedNumberOfChannels を決定するために使用されます。computedNumberOfChannels は以下のように決定されます。ミックスがどのように行われるかの詳細については、「§5 チャンネルのアップミックスとダウンミックス」 を参照してください。

| 列挙値の説明 | |

|---|---|

"max"

|

computedNumberOfChannels は入力となっている全接続のチャンネル数の最大値になります。このモードでは channelCount は無視されます。

|

"clamped-max"

|

computedNumberOfChannels は "max" のときと同じように計算されますが、指定された channelCount を上限として制限されます。

|

"explicit"

|

computedNumberOfChannels の値は channelCount によって指定された値そのものになります。

|

enum {ChannelInterpretation "speakers" ,"discrete" };

| 列挙値の説明 | |

|---|---|

"speakers"

|

アップミックス式 または ダウンミックス式 を使用します。チャンネル数がスピーカーの基本レイアウトに合致しない場合は、"discrete" に戻します。

|

"discrete"

| アップミックスの場合は、チャンネルを使い切るまで順に埋めて行き、余っているチャンネルには 0 を出力します。ダウンミックスでは、可能な限りチャンネルを順に埋め、余ったチャンネルは捨てられます。 |

1.5.2. 属性

channelCount, unsigned long 型-

channelCountはノードへの入力の接続におけるアップミックスおよびダウンミックスの際に使用されるチャンネル数です。値が別途定められている特定のノードを除いて、デフォルトは 2 です。この属性は入力を持たないノードでは意味を持ちません。もしこの値が 0、あるいは実装のチャンネル数の最大値より大きい値にセットされた場合、NotSupportedError例外を発生します ( MUST )。さらに、一部のノードではこれに加えてチャンネル数の制約があります:

AudioDestinationNode-

この動作は、接続先ノードが

AudioContextまたはOfflineAudioContextの宛先であるかどうかによって異なります:AudioContext-

チャンネル数は 1 以上から

maxChannelCount の間でなければなりません ( MUST )。この範囲外の値を設定しようとすると、IndexSizeError 例外を発生します ( MUST )。

OfflineAudioContext-

チャンネル数を変更することはできません。値を変更しようとすると、

InvalidStateError例外を発生します ( MUST )。

ChannelMergerNode-

チャンネル数を変更することはできません。値を変更しようとすると

InvalidStateError例外を発生します ( MUST )。 ChannelSplitterNode-

チャンネル数を変更することはできません。値を変更しようとすると

InvalidStateError例外を発生します ( MUST )。 ConvolverNode-

チャンネル数は 2 から変更することはできません。値を変更しようとすると

NotSupportedError例外を発生します ( MUST )。 DynamicsCompressorNode-

チャンネル数は 2 より大きくすることはできません。2 より大きな値に変更しようとすると

NotSupportedError例外を発生します ( MUST )。 PannerNode-

チャンネル数は 2 より大きくすることはできません。2 より大きな値に変更しようとすると

NotSupportedError例外を発生します ( MUST )。 ScriptProcessorNode-

チャンネル数を変更することはできません。値を変更しようとすると

InvalidStateError例外を発生します ( MUST )。 StereoPannerNode-

チャンネル数は 2 より大きくすることはできません。2 より大きな値に変更しようとすると

NotSupportedError例外を発生します ( MUST )。

この属性のより詳細な説明については、§5 チャンネルアップミキシングとダウンミキシング を参照してください。

channelCountMode, ChannelCountMode-

channelCountModeは、ノードの入力への接続をアップミキシングおよびダウンミックスするときに、チャンネルがどのようにカウントされるかを決定します。デフォルト値は "max" です。この属性は、入力のないノードには影響しません。さらに、一部のノードでは、チャンネル数モードが取れる値について channelCountMode の制約 があります。

AudioDestinationNode-

AudioDestinationNodeがOfflineAudioContextのdestinationノードである場合、チャンネル数モードは変更できません。値を変更しようとすると、InvalidStateError例外を発生します ( MUST )。 ChannelMergerNode-

チャンネル数モードは "

explicit" から変更できません。値を変更しようとするとInvalidStateError例外を発生します ( MUST )。 ChannelSplitterNode-

チャンネル数モードは "

explicit" から変更できません。値を変更しようとするとInvalidStateError例外を発生します ( MUST )。 ConvolverNode-

チャンネル数モードは "

clamped-max" から変更することはできません。値を変更しようとするとNotSupportedError例外を発生します ( MUST )。 DynamicsCompressorNode-

チャンネル数モードを "

max" に設定することはできません。"max" に設定しようとするとNotSupportedError例外を発生します ( MUST )。 PannerNode-

チャンネル数モードを "

max" に設定することはできません。"max" に設定しようとするとNotSupportedError例外を発生します ( MUST )。 ScriptProcessorNode-

チャンネル数モードは "

explicit" から変更できません。値を変更しようとするとInvalidStateError例外を発生します ( MUST )。 StereoPannerNode-

チャンネル数モードを "

max" に設定することはできません。"max" に設定しようとするとNotSupportedError例外を発生します ( MUST )。

この属性のより詳細な説明については、§5 チャンネルアップミキシングとダウンミキシング セクションを参照してください。

channelInterpretation, ChannelInterpretation 型-

channelInterpretationは、ノードへの入力への接続をアップミキシングおよびダウンミックスするときに、個々のチャンネルをどのように扱うかを決定します。デフォルト値は "speakers" です。この属性は、入力のないノードには影響しません。さらに、一部のノードでは、チャンネル解釈が取れる値に追加の channelInterpretation の制約があります。

ChannelSplitterNode-

チャンネルの解釈は "

discrete" から変更することはできません。値を変更しようとするとInvalidStateError例外を発生します ( MUST )。

この属性のより詳細な説明については、§5 チャンネルアップミキシングとダウンミキシング セクションを参照してください。

context, BaseAudioContext 型, readonly-

この

AudioNodeを所有するBaseAudioContextです。 numberOfInputs, unsigned long 型, readonly-

この

AudioNodeの入力の数です。ソースノードではこれは 0 になります。この属性は多くのAudioNodeのタイプで固定の値になりますが、ChannelMergerNodeやAudioWorkletNodeのようないくつかのAudioNodeでは入力の数は可変です。 numberOfOutputs, unsigned long 型, readonly-

この

AudioNodeから出る出力の数です。この属性はいくつかのAudioNodeでは固定の値ですが、ChannelSplitterNodeやAudioWorkletNodeなどでは可変になります。

1.5.3. メソッド

connect(destinationNode, output, input)-

あるノードの特定の出力から別のノードの特定の入力への接続は 1 つだけ存在できます。同じ端子間の複数回の接続は無視されます。

このメソッドは、

destinationのAudioNodeオブジェクトを返します。AudioNode.connect(destinationNode, output, input) メソッドの引数 パラメーター 型 Null可 省略可 説明 destinationNodedestinationパラメーターは接続先のAudioNodeです。もしdestinationが他のAudioContextによって作成されたAudioNodeの場合、InvalidAccessError例外を発生します ( MUST )。つまりAudioNodeは複数のAudioContext間で共有する事はできません。outputunsigned long ✘ ✔ outputパラメーターはAudioNodeのどの出力を接続するかを指定するインデックスです。もしこのパラメーターが範囲外の場合、IndexSizeError例外を発生します ( MUST )。 connect() を複数回呼び出してAudioNodeの出力から複数の入力に接続する事は可能です。つまり、"ファンアウト"がサポートされています。inputinputパラメーターは接続先のAudioNodeのどの入力に接続するかを指定するインデックスです。もしこのパラメーターが範囲外の場合、IndexSizeError例外を発生します ( MUST )。 あるAudioNodeから他のAudioNodeに循環を作るような接続を行う事も可能です: つまりあるAudioNodeから、最初のAudioNodeの入力かAudioParamに接続を行っている別のAudioNodeに対して接続を行う事ができます。これは循環の中に少なくとも 1 つのDelayNodeがある場合にのみ可能で、そうでなければNotSupportedError例外を発生します ( MUST )。戻り値:AudioNode connect(destinationParam, output)-

AudioNodeをAudioParamに接続し、パラメーターの値をオーディオレートの信号で制御します。connect() を複数回呼び出す事で

AudioNodeの出力を複数のAudioParamに接続する事が可能です。即ち、"ファンアウト"がサポートされています。connect() を複数回呼び出す事で、複数の

AudioNodeを 1 つのAudioParamに接続する事が可能です。即ち、"ファンイン"がサポートされています。AudioParamはそれに接続されている すべてのAudioNodeの出力からレンダリングされたオーディオデータを取り出し、それがモノラルでなければ、ダウンミックスによってモノラルに変換します。そして接続されている各出力をミックスし、さらに最終的にパラメーターが持っているタイムラインの変化スケジュールを含む固有値 (AudioParamに何も接続されていない状態でのvalue) とミックスします。モノラルへのダウンミックスは、

channelCount= 1、channelCountMode= "explicit"、およびchannelInterpretation= "speakers" のAudioNodeのダウンミックスに相当します。特定のノードの出力と特定の

AudioParamの間の接続は 1 つのみ存在できます。同じ終端点を持つ複数の接続は無視されます。AudioNode.connect(destinationParam, output) メソッドの引数 パラメーター 型 Null可 省略可 説明 destinationParamAudioParam ✘ ✘ destinationパラメーターは接続先の code class="idl">AudioParam です。このメソッドはdestinationのAudioParamオブジェクトを返しません。destinationParamが属するAudioNodeを作成したBaseAudioContextと、このメソッドが呼び出されたAudioNodeを作成したBaseAudioContextが異なる場合、InvalidAccessError例外を発生します ( MUST )。outputunsigned long ✘ ✔ outputパラメーターはAudioNodeのどの出力から接続するかを指定するインデックスです。もしparameterが範囲外の場合、IndexSizeError例外を発生します ( MUST )。戻り値:void disconnect()-

AudioNodeから出るすべての接続を切断します。パラメーターなし戻り値:void disconnect(output)-

AudioNodeの 1 つの出力から他のAudioNodeまたはAudioParamオブジェクトへの接続をすべて切断します。AudioNode.disconnect(output) メソッドの引数 パラメーター 型 Null可 省略可 説明 outputunsigned long ✘ ✘ このパラメーターは接続を切る AudioNodeの出力のインデックスです。これは与えられた出力から出るすべての接続を切断します。もしこのパラメーターが範囲外の場合、IndexSizeError例外を発生します ( MUST )。戻り値:void disconnect(destinationNode)-

AudioNodeのすべての出力から特定の接続先となるAudioNodeに繋がる接続を切断します。AudioNode.disconnect(destinationNode) メソッドの引数 パラメーター 型 Null可 省略可 説明 destinationNodedestinationNodeパラメーターは切断するAudioNodeです。これは与えられたdestinationNodeに対するすべての接続を切断します。もしdestinationNodeに対する接続がない場合、InvalidAccessError例外を発生します ( MUST )。戻り値:void disconnect(destinationNode, output)-

AudioNodeの特定の出力から特定の接続先AudioNode入力への接続を切断します。AudioNode.disconnect(destinationNode, output) メソッドの引数 パラメーター 型 Null可 省略可 説明 destinationNodedestinationNodeパラメーターは切断するAudioNodeです。もし与えられた出力からdestinationNodeに対する接続がない場合、InvalidAccessError例外を発生します ( MUST )。outputunsigned long ✘ ✘ outputパラメーターは接続を切るAudioNodeの出力を表すインデックスです。もしこのパラメーターが範囲外の場合はIndexSizeError例外を発生します ( MUST )。戻り値:void disconnect(destinationNode, output, input)-

AudioNodeの特定の出力から 接続先AudioNodeの特定の入力への接続を切断します。AudioNode.disconnect(destinationNode, output, input) メソッドの引数 パラメーター 型 Null可 省略可 説明 destinationNodedestinationNodeパラメーターは切断する code class="idl">AudioNode です。もし与えられた出力からdestinationNodeへの接続が存在しない場合、InvalidAccessError例外を発生します ( MUST )。outputunsigned long ✘ ✘ outputパラメーターは切断するAudioNodeの出力のインデックスです。もしこのパラメーターが範囲外の場合、IndexSizeError例外を発生します ( MUST )。inputinputパラメーターは切断する接続先AudioNodeの入力のインデックスです。もしこのパラメーターが範囲外の場合、IndexSizeError例外を発生します ( MUST )。戻り値:void disconnect(destinationParam)-

特定の接続先

AudioParamに繋がるAudioNodeのすべての出力を切断します。この操作によって、このAudioNodeからパラメーター値の計算への寄与は 0 となります。パラメーターの固有値はこの操作に影響されません。AudioNode.disconnect(destinationParam) メソッドの引数 パラメーター 型 Null可 省略可 説明 destinationParamAudioParam ✘ ✘ destinationParamパラメーターは切断するAudioParamです。もしdestinationParamに対する接続がない場合はInvalidAccessError例外を発生します ( MUST )。戻り値:void disconnect(destinationParam, output)-

AudioNodeの特定の出力から特定のAudioParamへの接続を切断します。この操作によって、このAudioNodeからパラメーター値の計算への寄与は 0 となります。パラメーターの固有値はこの操作に影響されません。AudioNode.disconnect(destinationParam, output) メソッドの引数 パラメーター 型 Null可 省略可 説明 destinationParamAudioParam ✘ ✘ destinationParamパラメーターは切断されるAudioParamです。もしdestinationParamへの接続が存在しない場合、InvalidAccessError例外を発生します ( MUST )。outputunsigned long ✘ ✘ outputパラメーターは切断されるAudioNodeの出力のインデックスです。もし、parameterが範囲外の場合、IndexSizeError例外を発生します ( MUST )。戻り値:void

1.5.4. AudioNodeOptions

これは、すべての AudioNode の生成の際に使用できるオプションを指定します。すべてのメンバーはオプションです。ただし、それぞれのノードで使われる値は、実際のノードに依存します。

dictionary AudioNodeOptions {unsigned long channelCount ;ChannelCountMode channelCountMode ;ChannelInterpretation channelInterpretation ; };

1.5.4.1. ディクショナリ AudioNodeOptions メンバー

channelCount, unsigned long 型-

channelCount属性に要求するチャンネル数です。 channelCountMode, ChannelCountMode 型-

channelCountMode属性に要求するモードです。 channelInterpretation, ChannelInterpretation 型-

channelInterpretation属性に要求するモードです。

1.5.5. ライフタイム

以下の振る舞いは、AudioNode が存在し続ける、つまり実装によってグラフ内に保持される ( MUST ) ための条件の基準となります。これらの条件が満たされなくなった場合、AudioNode は実装によって解放されるかもしれません。

参照には何種類かのタイプがあります:

-

通常の参照。通常のガベージコレクションのルールに従います。

-

AudioBufferSourceNode、MediaElementAudioSourceNode、MediaStreamAudioSourceNode、OscillatorNodeの再生中の参照。これらのノードは再生している間、自分自身への再生中参照を維持します。 -

接続の参照。別の

AudioNodeから 1 つ以上の入力に接続されている場合に発生します。ノードのAudioParamに接続されている事は参照にはなりません。 -

tail-time による参照。

AudioNodeは何かしらの内部プロセスで未出力の状態がある間、自分自身を維持します。例えば、ConvolverNodeは無音の入力を受けた後でも再生し続ける余韻を持ちます ( 大きなコンサートホールで手を叩くと、ホール中に響きわたる音が聞こえるのをイメージしてください )。いくつかのAudioNodeは、この特性を持ちます。各ノードの詳細を見てください。 -

MediaStream は、その下層の MediaStreamTrack が

MediaStreamAudioSourceNodeを通して再生しているとき、( [mediacapture-streams] に従って ) 終了 状態になるまでMediaStreamAudioSourceNodeを有効状態に保持します。 -

HTMLMediaElementでは、この後、そのHTMLMediaElementが、オーディオを再生できる状態にある限り、関連付けられたMediaElementAudioSourceNodeを有効に保ちます。注 :

HTMLMediaElementが、src属性を""に設定され、その参照がすべてなくなったとき、MediaElementAudioSourceNodeも解放されます (MediaElementAudioSourceNodeはすべてを解放し、保持するものはありません )。

循環で接続され、且つ、AudioContext 内の AudioDestinationNode または MediaStreamAudioDestinationNode に直接的または間接的に接続されている AudioNode は AudioContext が存続している限り有効に保持され続けます。

注 : AudioNode の継続的な動作はそのノードへの暗黙的な参照が存在しているという事を意味し、たとえオーディオグラフから切断されていても、ノードは入力を処理し続け、内部状態を更新し続けます。この処理は CPU と電力を消費し続けるため、開発者は注意深く切り離されたノードによるリソースの使用について考慮しなくてはなりません。特に、可能なときは明示的に切断されたノードを停止状態にする事でリソースの消費を最小化するのは良い考えです。

AudioNode は参照がなくなった時、削除されます。 また、削除する前に、接続されている他の AudioNode から切断され、他のノードに対する接続参照 (3) をすべて解放します。

上記の参照に関わらず、AudioNode は、その AudioContext が削除されたときには削除されます。

1.6. AudioParam インターフェイス

AudioParam は AudioNode の例えば音量のような個別の機能をコントロールします。パラメーターは value 属性を使って特定の値に即時にセットする事ができます。あるいは ( AudioContext の currentTime 属性の時間軸で ) 非常に高い時間精度で値の変化のスケジュールを組む事ができ、エンベロープ、音量のフェード、LFO、フィルタースイープ、グレイン窓、などに応用する事ができます。このような方法で任意のタイムラインベースのオートメーション曲線をすべての AudioParam に対して設定する事が可能です。またさらに、AudioNode からの出力の音声信号を AudioParam に接続する事ができ、個別に持っているパラメーターの固有値に加算する事ができます。

いくつかの合成や処理の AudioNode は、オーディオサンプル単位で反映されなくてはならない ( MUST ) AudioParam 型の属性を持っています。その他の AudioParam はサンプル単位の精度は重要ではなく、その値の変化はより粗く取り込まれます。各 AudioParam は a-rate パラメーターつまりサンプル単位で反映される ( MUST )か、それ以外の k-rate パラメーターかが指定されます。

実装はそれぞれの AudioNode について、1 レンダリング量子 ごとのブロック単位の処理を行わなくてはなりません ( MUST )。

それぞれの レンダリング量子 に対して、k-rate パラメーターは最初のサンプルのタイミングで取り込まれ、その値はブロック全体に対して使用されなくてはなりません ( MUST )。a-rate パラメーターはブロック内のサンプルフレームごとに取り込まれなくてはなりません ( MUST )。 AudioParam によっては、automationRate 属性を "a-rate" または "k-rate" のいずれかに設定することによって、レートを制御できます。詳細については、個々の AudioParam の説明を参照してください。

各 AudioParam は minValue および maxValue 属性を持っており、それがパラメーターの単純な公称範囲となっています。実際のパラメーターの値は \([\mathrm{minValue}, \mathrm{maxValue}]\) の範囲に制限されます。詳細は、「§ 1.6.3 値の計算」 を参照してください。

多くの AudioParam では、minValue と maxValue は可能な最大限の範囲に設定されています。この場合、maxValue は、最も正の単精度浮動小数点値 ( 3.4028235e38 ) となります。( ただし、JavaScript では IEEE-754 倍精度浮動小数点値のみをサポートするため、これは 3.4028234663852886e38 と書かなくてはなりません ) 同様に、minValue は最も負の単精度浮動小数点値、つまり 最も正の単精度浮動小数点値 の符号を負にしたもの: -3.4028235e38 となります。( 同様に、これは JavaScript では -3.4028234663852886e38 として記述する必要があります )。

AudioParam は、0 個以上のオートメーションイベントのリストを保持しています。各オートメーションイベントは、AudioContext の currentTime 属性の時間軸におけるオートメーションイベント時刻に関連して、特定の時間範囲にわたるパラメーター値の変更を指定します。オートメーションイベントのリストは、オートメーションイベント時刻の昇順で管理されます。

オートメーションイベントの振る舞いは、AudioContext の現在の時刻とこのイベントのオートメーションイベント時刻とリスト内に隣接するイベントの関数になります。以下のオートメーションメソッドは、そのメソッドに固有のタイプの新しいイベントをイベントリストに追加し、変更します:

-

setValueAtTime()-SetValue -

linearRampToValueAtTime()-LinearRampToValue -

exponentialRampToValueAtTime()-ExponentialRampToValue -

setTargetAtTime()-SetTarget -

setValueCurveAtTime()-SetValueCurve

これらのメソッドが呼ばれるとき、次の規則が適用されます:

-

オートメーションイベント時刻 は、使われるサンプルレートに対して量子化されません。カーブと傾斜を決定する式では、イベントをスケジューリングするときに与えられた正確な時刻を使用されます。

-

これらのイベントが、リストの中で既に 1 つまたは複数のイベントが存在する時刻に追加された場合、そのイベントの後で、時刻がより後ろのイベントの前に追加されます。

-

If setValueCurveAtTime() が時刻 \(T\) と持続時間 \(D\) を指定して呼ばれたとき、\(T\) より後ろで \(T + D\) より手前に何らかのイベント既に存在している場合、

NotSupportedError例外を発生します ( MUST )。 言い換えれば、他のイベントを含む期間に値のカーブをスケジュールする事はできません。 -

同様に、時刻 \(T\) と 持続時間 \(D\) で示される期間 \([T, T+D)\), \(T\) に含まれる時刻を指定して何らかのオートメーションメソッドを呼んだ場合、

NotSupportedError例外を発生します ( MUST )。

注 : AudioParam の属性は、value 属性を除いて、読み取り専用です。

AudioParam のオートメーションレートは、automationRate 属性を次のいずれかの値で設定して選択できます。ただし、一部の AudioParam では、オートメーションレートを変更できるかどうかについて制約があります。

enum {AutomationRate "a-rate" ,"k-rate" };

| 列挙値の説明 | |

|---|---|

"a-rate"

|

この AudioParam は、a-rate での処理に設定されます。

|

"k-rate"

|

この AudioParam は、k-rate での処理に設定されます。

|

各 AudioParam には内部スロット [[current value]] があり、AudioParam の defaultValue に初期設定されています。

[Exposed =Window ]interface AudioParam {attribute float value ;attribute AutomationRate automationRate ;readonly attribute float defaultValue ;readonly attribute float minValue ;readonly attribute float maxValue ;AudioParam setValueAtTime (float ,value double );startTime AudioParam linearRampToValueAtTime (float ,value double );endTime AudioParam exponentialRampToValueAtTime (float ,value double );endTime AudioParam setTargetAtTime (float ,target double ,startTime float );timeConstant AudioParam setValueCurveAtTime (sequence <float >,values double ,startTime double );duration AudioParam cancelScheduledValues (double );cancelTime AudioParam cancelAndHoldAtTime (double ); };cancelTime

1.6.1. 属性

automationRate, AutomationRate 型-

AudioParamのオートメーションの速度です。デフォルト値は実際のAudioParamに依存します。デフォルト値についてはAudioParamの説明を参照してください。いくつかのノードには、次のような追加のオートメーション速度の制約があります:

AudioBufferSourceNode-

AudioParamのplaybackRateとdetuneは "k-rate" でなくてはなりません ( MUST )。速度が "a-rate" に変更された場合は、a-rateが発生します。 DynamicsCompressorNode-

AudioParamのthreshold、knee、ratio、attack、およびreleaseは、"k-rate" でなければなりません ( MUST )。速度が "a-rate" に変更された場合、InvalidStateErrorが発生します。 PannerNode-

panningModelが "HRTF" の場合、PannerNodeのすべてのAudioParamに対するautomationRateの設定は無視されます。同様に、AudioListenerのすべてのAudioParamのautomationRateの設定は無視されます。この場合、AudioParamは、automationRateが "k-rate" に設定されているかのように動作します。

defaultValue, float 型, readonly-

value属性の初期値です。 maxValue, float 型, readonly-

パラメーターが取ることができる名目上の最大値です。

minValueと組み合わせて、これはこのパラメーターの 公称範囲 となります。 minValue, float 型, readonly-

パラメーターが取ることができる名目上の最小値です。

maxValueと組み合わせて、これはこのパラメーターの 公称範囲 となります。 value, float 型-

パラメーターの浮動小数点の値です。この属性の初期値は

defaultValueとなります。この属性を読み取ると、

[[current value]]スロットの内容が返されます。これは、オーディオのレンダリングスレッドの最も直近のレンダリング量子の最後でのこのパラメーターの値、あるいはレンダリングが行われていない場合は、最も直近に割り当てられた値を保持しています。この属性を設定すると、要求された値を

[[current value]]スロットに割り当て、現在のAudioContextのcurrentTimeと[[current value]]を使って setValueAtTime() メソッドを呼び出す効果があります。この属性を設定することでsetValueAtTime()による例外が発生する事もあります。

1.6.2. メソッド

cancelAndHoldAtTime(cancelTime)-

これは

cancelTimeと同じかそれ以降の時刻のスケジュールされたすべてのパラメーターの変化をキャンセルするという点でcancelScheduledValues()と似ていますが、それに加えてcancelTimeの時点でのオートメーション値が、他のオートメーションイベントが起こるまで、保持されます。オートメーションが動作中に

cancelAndHoldAtTime()を呼び出してからcancelTimeに達するまでの任意の時間のcancelAndHoldAtTime()に対するタイムラインの動作は非常に複雑です。cancelAndHoldAtTime()の動作は、次のアルゴリズムで定義されます。\(t_c\) をcancelTimeの値とします。そして、-

時刻 \(t_1\) におけるイベントを ( 存在すれば ) \(E_1\) とし、\(t_1\) が \(t_1 \le t_c\) を満たす最大の数であるとします。

-

時間 \(t_2\) におけるイベントを ( 存在すれば ) \(E_2\) とし、\(t_2\) が \(t_c \lt t_2\) を満たす最小の数であるとします。

-

もし \(E_2\) が存在すれば:

-

もし、\(E_2\) が linear または exponential カーブの場合、

-

実質的に \(E_2\) を書き換えて、時刻 \(t_c\) に終了し、最終値が元の傾斜の \(t_c\) の時点の値とである同じ種類の傾斜とします。

-

ステップ 5. に行きます。

-

-

そうでなければ ステップ 4. に行きます。

-

-

もし \(E_1\) が存在すれば:

-

もし \(E_1\) が

setTargetイベントの場合、-

時刻 \(t_c\) に

setValueAtTimeイベントを暗黙的に挿入し、setTargetが時刻 \(t_c\) に持つであろう値とします。 -

ステップ 5. に行きます。

-

-

もし \(E_1\) が

setValueCurveで、開始時刻が \(t_3\) 、持続時間が \(d\) の場合-

もし \(t_c \gt t_3 + d\) ならば ステップ 5. に行きます。

-

そうでなければ、

-

実質的にこのイベントを、開始時刻が \(t_3\)、新しい持続時間が \(t_c-t_3\) の

setValueCurveイベントで置き換えます。しかしながら、これは単なる置き換えではありません。このオートメーションは、オリジナルと同じ出力を生成するために留意しなくてはならず ( MUST )、ただ異なる持続時間を使用して計算された出力ではありません。( これだと、値の曲線を少し違う方法でサンプリングして、異なる結果を生じることになります )。 -

ステップ 5. に行きます。

-

実質的にこのイベントを、開始時刻が \(t_3\)、新しい持続時間が \(t_c-t_3\) の

-

-

-

時刻 \(t_c\) より後ろのすべてのイベントを削除します。

イベントが追加されない場合は、

cancelAndHoldAtTime()の後のオートメーション値は、元のタイムラインが時刻 \(t_c\) に持つ定数値となります。AudioParam.cancelAndHoldAtTime() メソッドの引数 パラメーター 型 Null可 省略可 説明 cancelTimedouble ✘ ✘ この時刻以降の以前スケジュールされたパラメーターの変化はキャンセルされます。これは、 AudioContextのcurrentTime属性と同じ時間軸の時刻です。もしcancelTimeが負であるか、有限数でない場合、RangeError例外を発生します ( MUST )。cancelTimeがcurrentTimeより小さい場合は、currentTimeにクランプされます。戻り値:AudioParam -

cancelScheduledValues(cancelTime)-

cancelTimeと同じか後ろの時刻にスケジュールされたすべてのパラメーター変化を取り消します。スケジュールされたパラメーター変化を取り消すという事は、スケジュールされたイベントをイベントリストから削除することを意味します。オートメーションイベントの時刻 がcancelTime未満の現在動作中のオートメーションも取り消され、( そのオートメーション以前の ) 直前の値が直ちに復元されるため、このような取り消しは不連続を引き起こす可能性があります。cancelAndHoldAtTime()によってスケジュールされたすべてのホールド値で、cancelTimeの後ろにホールドの時刻が発生した場合にもまた削除されます。AudioParam.cancelScheduledValues() メソッドの引数 パラメーター 型 Null可 省略可 説明 cancelTimedouble ✘ ✘ この時刻以降で以前にスケジュールされたパラメーター変化はキャンセルされます。これは、 AudioContextのcurrentTime属性と同じ時間軸の時刻です。もしcancelTimeが負であるか、有限数でない場合、RangeError例外を発生します ( MUST )。cancelTimeがcurrentTimeより小さい場合は、currentTimeにクランプされます。戻り値:AudioParam exponentialRampToValueAtTime(value, endTime)-

前にスケジュールされているバラメーター値から指定された値まで、指数的に連続して値を変化させる事をスケジュールします。フィルターの周波数や再生スピードなどのパラメーターは人間の聴覚特性のため、指数的変化が適しています。

時間範囲 \(T_0 \leq t < T_1\) ( ここで \(T_0\) は前のイベントの時刻で \(T_1\) はこのメソッドに渡された

endTimeパラメーターです ) に対して次のように計算されます:$$ v(t) = V_0 \left(\frac{V_1}{V_0}\right)^\frac{t - T_0}{T_1 - T_0} $$ここで \(V_0\) は時刻 \(T_0\) での値、\(V_1\) はこのメソッドに渡された

valueパラメーターです。もし \(V_0\) と \(V_1\) が、逆の符号を持つか \(V_0\) が 0 ならば、\(T_0 \le t \lt T_1\) に対して \(v(t) = V_0\) となります。これはまた、0 に向かう指数カーブが不可能である事も示しています。

setTargetAtTime()で適当な時間定数を選択する事で良い近似を得る事ができます。もしこの ExponentialRampToValue イベント以降のイベントがない場合 t≥T1, v(t)=V1 となります

もしこのイベントより前にイベントが存在しない場合、指数カーブは

setValueAtTime(value, currentTime)が呼び出されたかのように動作します。ここで、valueは属性の現在の値で、currentTimeはexponentialRampToValueAtTime呼び出されたときのコンテキストのcurrentTimeです。もし、前のイベントが

SetTargetイベントの場合、\(T_0\) と \(V_0\) はSetTargetオートメーションの現在の時刻と値から選択されます。SetTargetイベントがまだ開始されていない場合、\(T_0\) はイベントの開始時刻であり、\(V_0\) はSetTargetイベントの開始直前の値です。ExponentialRampToValueイベントは実質的にSetTargetイベントを置き換えます。SetTargetイベントが既に開始されている場合、\(T_0\) は現在のコンテキストの時刻であり、\(V_0\) は時刻 \(T_0\) での現在のSetTargetオートメーションの値です。どちらの場合も、オートメーション曲線は連続しています。AudioParam.exponentialRampToValueAtTime() メソッドの引数 パラメーター 型 Null可 省略可 説明 valuefloat ✘ ✘ パラメーターが指数変化により指定された時刻に到達する値です。この値が 0 の場合、 RangeError例外を発生します ( MUST )。endTimedouble ✘ ✘ AudioContextのcurrentTime属性と同じ時間軸で、指数変化が終了する時刻です。 もし endTime が負の値または有限数でない場合RangeError例外を発生します ( MUST )。 もし endTime がcurrentTimeよりも小さい場合、currentTimeにクランプされます。戻り値:AudioParam linearRampToValueAtTime(value, endTime)-

前にスケジュールされているパラメーター値から指定された値まで、直線的に連続して値を変化させる事をスケジュールします。

時間範囲 \(T_0 \leq t < T_1\) ( ここで \(T_0\) は前のイベントの時刻、\(T_1\) はこのメソッドで指定された

endTimeです ) の間の値は次のように計算されます:$$ v(t) = V_0 + (V_1 - V_0) \frac{t - T_0}{T_1 - T_0} $$ここで \(V_0\) は時刻 \(T_0\) での値、\(V_1\) はこのメソッドで指定された

valueです。もしこの LinearRampToValue イベント以降にイベントがない場合、\(t \geq T_1\), \(v(t) = V_1\) となります。

もしこのイベントにより前にイベントが存在しない場合、直線変化は

setValueAtTime(value, currentTime)が呼び出されたかのように動作します。ここで、valueは属性の現在の値で、currentTimeはlinearRampToValueAtTimeが呼び出されたときのコンテキストのcurrentTimeです。もし、前のイベントが

SetTargetイベントの場合、\(T_0\) と \(V_0\) はSetTargetオートメーションの現在の時刻と値から選択されます。つまり、SetTargetイベントがまだ開始されていない場合、\(T_0\) はイベントの開始時刻であり、\(V_0\) はSetTargetイベントの開始直前の値です。この場合、LinearRampToValueイベントは実質的にSetTargetイベントを置き換えます。SetTargetイベントが既に開始されている場合、\(T_0\) は現在のコンテキストの時刻であり、\(V_0\) は時刻 \(T_0\) での現在のSetTargetオートメーションの値です。どちらの場合も、オートメーションの曲線は連続しています。AudioParam.linearRampToValueAtTime() メソッドの引数 パラメーター 型 Null可 省略可 説明 valuefloat ✘ ✘ 与えられた時刻にパラメーターが直線変化で到達する値です。 endTimedouble ✘ ✘ code class="idl">AudioContext の currentTime属性と同じ時間軸で、オートメーションが終了する時刻です。もしendTimeが負の値または有限数でない場合RangeError例外を発生します ( MUST )。 もし endTime がcurrentTimeよりも小さい場合、currentTimeにクランプされます。戻り値:AudioParam setTargetAtTime(target, startTime, timeConstant)-

指定の時刻から、指定の時定数によって指数的に目標の値に漸近を開始します。様々な使い方がありますが、これは ADSR エンベロープの "ディケイ" および "リリース" を実装する際に役立ちます。値は指定の時刻に即、目標値になるのではなく徐々に目標値に向かって変化する事に注意してください。

時間範囲 \(T_0 \leq t\) について、ここで \(T_0\) は

startTimeパラメーターの時刻として :$$ v(t) = V_1 + (V_0 - V_1)\, e^{-\left(\frac{t - T_0}{\tau}\right)} $$ここで、\(V_0\) は \(T_0\) (

startTimeパラメーター ) での初期値 (.value属性の値 )、\(V_1\) はtargetパラメーターの値、そして \(\tau\) はtimeConstantパラメーターです。LinearRampToValueまたはExponentialRampToValueイベントがこのイベントの後に続く場合、その動作はそれぞれlinearRampToValueAtTime()またはexponentialRampToValueAtTime()で説明しています。他のすべてのイベントの場合は、SetTargetイベントは次のイベントの時点で終了します。AudioParam.setTargetAtTime() メソッドの引数 パラメーター 型 Null可 省略可 説明 targetfloat ✘ ✘ パラメーターが指定の時刻から変化を開始する際の目標値です。 startTimedouble ✘ ✘ AudioContextのcurrentTime属性と同じ時間軸で指数的漸近を開始する時刻です。もしstartが負の値または有限数でない場合はRangeError例外を発生します ( MUST )。 もし、startTime が code class="idl">currentTime よりも小さい場合、currentTimeの値にクランプされます。timeConstantfloat ✘ ✘ 目標値に漸近する一次フィルター ( 指数 ) の時定数です。この値が大きいと変化はゆっくりになります。値は負の値ではならず ( MUST )、そうでない場合 RangeError例外を発生します ( MUST )。 もしtimeConstantがゼロの場合、出力値は直ちに最終値にジャンプします。より正確には、timeConstant は、ステップ入力応答 ( 0 から 1 への遷移 ) が与えられた場合、一次線形連続時間不変システムが値 \(1 - 1/e\) ( 約 63.2% ) に達する時間です。戻り値:AudioParam setValueAtTime(value, startTime)-

指定の時刻になるとパラメーター値を変更するようにスケジュールします。

もしこの

もしこのSetValueイベントの後にもうイベントがない場合、\(t \geq T_0\) に対して \(v(t) = V\) ここで \(T_0\) はstartTime、そして \(V\) はvalueパラメーターの値です。別の言い方をすれば、値は定数のまま保持されます。SetValueイベントの次のイベント ( 時刻は \(T_1\) ) がLinearRampToValueまたはExponentialRampToValueでない場合、\(T_0 \leq t < T_1\) に対して:$$ v(t) = V $$

別の言い方をすれば、値に "ステップ" を作ってこの期間定数のまま保持されます。

この

SetValueイベントに続く次のイベントがLinearRampToValueまたはExponentialRampToValueの場合、linearRampToValueAtTime()またはexponentialRampToValueAtTime()をそれぞれ参照してください。AudioParam.setValueAtTime() メソッドの引数 パラメーター 型 Null可 省略可 説明 valuefloat ✘ ✘ 指定の時刻にパラメーターが変化する値です。 startTimedouble ✘ ✘ BaseAudioContextのcurrentTime属性と同じ時間軸で与えられた値に変化する時刻です。 もしstartTimeが負の値または有限数でない場合はRangeError例外を発生します ( MUST )。 もし startTime がcurrentTimeよりも小さい場合、currentTimeにクランプされます。戻り値:AudioParam setValueCurveAtTime(values, startTime, duration)-

指定の時刻と期間に対して、任意の値の配列を設定します。値の個数は必要とされる期間に合うようにスケーリングされます。

\(T_0\) を

startTime、\(T_D\) をduration、\(V\) をvalues配列、\(N\) をvalues配列の長さとすると、期間 \(T_0 \le t < T_0 + T_D\) の間、次のようになります:$$ \begin{align*} k &= \left\lfloor \frac{N - 1}{T_D}(t-T_0) \right\rfloor \\ \end{align*} $$そして \(v(t)\) は \(V[k]\) と \(V[k+1]\) の間で直線補間されます。

曲線の期間が終了した後、(\(t \ge T_0 + T_D\)) に対して値は ( もしあれば ) 別のオートメーションイベントまで、最後の曲線の値を保持します。

時刻 \(T_0 + T_D\) 、値 \(V[N-1]\) として暗黙的な

setValueAtTime()の呼び出しが行われ、以後のオートメーションはsetValueCurveAtTime()イベントの終わりから開始するようになります。AudioParam.setValueCurveAtTime() メソッドの引数 パラメーター 型 Null可 省略可 説明 valuessequence<float> ✘ ✘ パラメーター値の曲線を表す float 値のシーケンスです。これらの値は、指定された時刻から開始される、指定された期間に割り当てられます。このメソッドが呼び出されると、オートメーションのためにカーブの内部的なコピーが作成されます。そのため、それ以降に渡した配列の中身を変更しても AudioParamに対する効果はありません。この属性のsequence<float>オブジェクトの長さが 2 未満の場合、InvalidStateErrorが発生します ( MUST )。startTimedouble ✘ ✘ AudioContextのcurrentTime属性と同じ時間軸の曲線の適用を開始する時刻です。もしstartTimeが負の値または有限数でない場合RangeError例外を発生します ( MUST )。もし startTime がcurrentTimeよりも小さい場合、currentTimeの値にクランプされます。durationdouble ✘ ✘ ( startTimeパラメーターの時刻の後 )valuesパラメーターに基づいて値が計算される期間の秒数です。durationが ( 訳注: 0 を含まない )厳密に正でないか、有限数でない場合、RangeError例外を発生します ( MUST )。戻り値:AudioParam

1.6.3. 値の計算

AudioParam には、単純パラメーター と 複合パラメーター という 2 つの異なる種類があります。単純パラメーター ( デフォルト ) は、AudioNode の最終的なオーディオ出力を計算するために単独で使用されます。複合パラメーターは、他の AudioParam と一緒に合わせて計算された値が、AudioNode の出力を計算するための入力となる AudioParam です。

computedValue はオーディオ DSP を制御する最終的な値であり、オーディオレンダリングスレッドによって、それぞれのレンダリング量子の時刻に計算します。内部的には次のように計算されなくてはなりません ( MUST ):

-

固有のパラメーター値は、

value属性に直接値が設定されたとき、あるいは、あらかじめまたはこの時刻に設定された オートメーションイベント があれば、これらのイベントから計算されます。 読み取られると、value属性は常に現在の時刻の固有値を返します。オートメーションイベントが特定の時間範囲から削除された場合、value属性が直接設定されるか、時間範囲に対してオートメーションイベントが追加されるまで、固有値は変更されずに以前の値にとどまります。 -

computedValue は、固有値と 入力 AudioParam バッファー の値の合計です。読み取られた場合、

value属性は常に現在の時刻の computedValue を返します。 -

もしこの

AudioParamが 複合パラメーター の場合、他のAudioParamと合わせて最終的な値を計算します。

computedValue の公称範囲は、このパラメーターが実質的に持つことができる最小値と最大値です。単純パラメーター の場合、computedValue はこのパラメーターの 単純な公称範囲 内にクランプされます。複合パラメーター では、複合される別の AudioParam の値と合わせて計算された後、最終的な値が 公称範囲 にクランプされます。

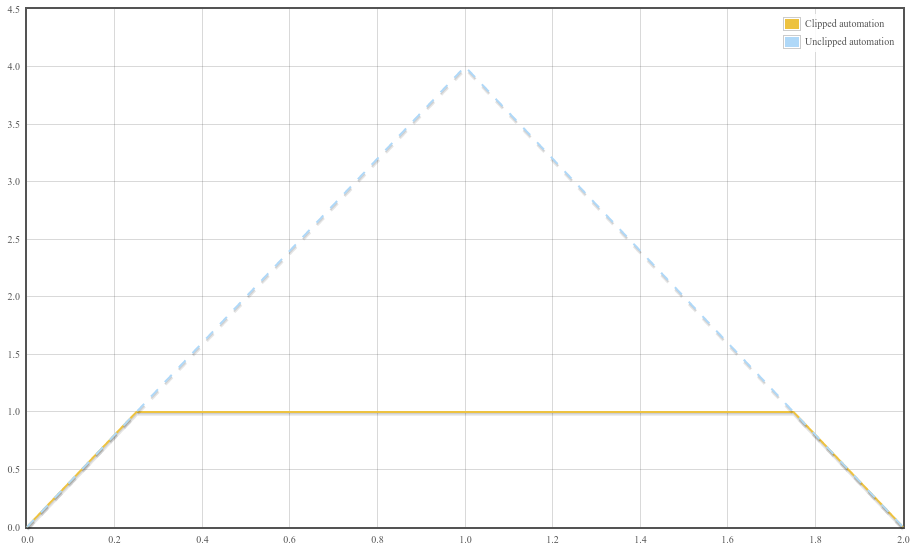

オートメーションメソッドを使用する場合にも、クランプは依然として適用されます。ただし、オートメーション自体はクランプが全くないかのように実行され、オートメーションの値が出力される際にのみ、上記のクランプが実行されます。

N. p. setValueAtTime( 0 , 0 ); N. p. linearRampToValueAtTime( 4 , 1 ); N. p. linearRampToValueAtTime( 0 , 2 );

曲線の最初の勾配は 4 であり、最大値 1 に達すると出力は一定に保たれます。最後に、時刻 2 の近くで、曲線の傾きは -4 になります。これを図示したのが下のグラフで、破線はクリッピングされない場合に何が起こったかを示し、実線は公称範囲へのクリッピングによる audioparam の実際の予想される動作を示しています。

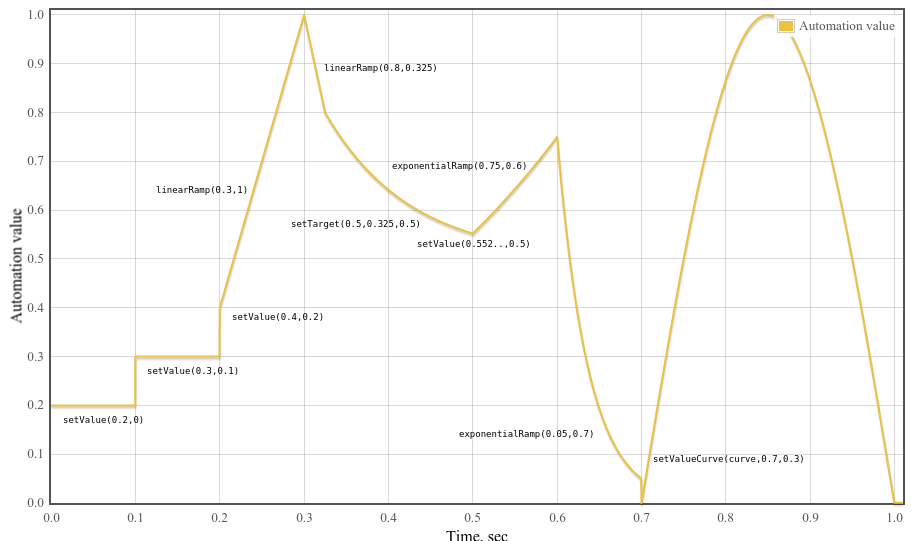

1.6.4. AudioParam オートメーションの例

var curveLength= 44100 ; var curve= new Float32Array( curveLength); for ( var i= 0 ; i< curveLength; ++ i) curve[ i] = Math. sin( Math. PI* i/ curveLength); var t0= 0 ; var t1= 0.1 ; var t2= 0.2 ; var t3= 0.3 ; var t4= 0.325 ; var t5= 0.5 ; var t6= 0.6 ; var t7= 0.7 ; var t8= 1.0 ; var timeConstant= 0.1 ; param. setValueAtTime( 0.2 , t0); param. setValueAtTime( 0.3 , t1); param. setValueAtTime( 0.4 , t2); param. linearRampToValueAtTime( 1 , t3); param. linearRampToValueAtTime( 0.8 , t4); param. setTargetAtTime( .5 , t4, timeConstant); // Compute where the setTargetAtTime will be at time t5 so we can make // the following exponential start at the right point so there’s no // jump discontinuity. From the spec, we have // v(t) = 0.5 + (0.8 - 0.5)*exp(-(t-t4)/timeConstant) // Thus v(t5) = 0.5 + (0.8 - 0.5)*exp(-(t5-t4)/timeConstant) param. setValueAtTime( 0.5 + ( 0.8 - 0.5 ) * Math. exp( - ( t5- t4) / timeConstant), t5); param. exponentialRampToValueAtTime( 0.75 , t6); param. exponentialRampToValueAtTime( 0.05 , t7); param. setValueCurveAtTime( curve, t7, t8- t7);

1.7. AudioScheduledSourceNode インターフェイス

このインターフェイスは、AudioBufferSourceNode、ConstantSourceNode、および code class="idl">OscillatorNode などのソースノードの共通の機能を表します。

( start() を呼び出すことによって ) ソースが開始されるより前は、ソースノードは無音 ( 0 ) を出力しなければなりません ( MUST )。( stop() を呼び出すことによって ) ソースが停止した後、ソースは無音 ( 0 ) を出力しなければなりません ( MUST )。

AudioScheduledSourceNode は直接インスタンス化することはできませんが、代わりにソースノードの具体的なインターフェイスに拡張されています。

[Exposed =Window ]interface AudioScheduledSourceNode :AudioNode {attribute EventHandler onended ;void start (optional double when = 0);void stop (optional double when = 0); };

1.7.1.

onended, EventHandler 型-

この属性は

AudioScheduledSourceNode型のノードに送られる ended イベントのEventHandler( HTML[HTML]) で説明されています ) を設定します。( 実体化したノードによって決まる方法で ) ソースノードが再生を停止したときEvent型のイベント ( HTML [HTML] で説明されています ) がイベントハンドラーに送られます。すべての

AudioScheduledSourceNodeは、stop()によって指定された停止時間に達するとonendedイベントが送出されます。AudioBufferSourceNodeの場合はdurationに達するか、バッファー全体を再生し終わったときもイベントが送出されます。

1.7.2. メソッド

start(when)-

指定した時刻に音を再生するようにスケジュールします。

このメソッドが呼ばれると以下の手順を実行します:-

このノードで

stop()が既に呼び出されている場合、またはstart()が既に呼び出されている場合は、InvalidStateError例外を発生します ( MUST )。 -

後述するパラメーターの制約のために発生するエラーがないか調べます。

-

AudioScheduledSourceNodeを開始するための制御メッセージをパラメーターと共にキューに入れます。

AudioScheduledSourceNode.start(when) メソッドの引数 パラメーター 型 Null可 省略可 説明 whendouble ✘ ✔ whenパラメーターは、サウンドの再生開始時刻を秒単位で表します。これは、AudioContextのcurrentTime属性と同じ時間軸を使用します。AudioScheduledSourceNodeが信号を出力する際の開始時刻を示すwhenは常にサンプルフレーム単位に丸めずに使用されます。この値に 0 が渡された場合、または値が currentTime よりも小さい場合は、サウンドが即時に再生されます。whenが負の場合にはRangeError例外を発生します ( MUST )。戻り値:void -

stop(when)-

正確な時刻に音の再生を停止するようにスケジュールします。

stopがすでに呼び出された後に再度呼び出された場合は、最後の呼び出しだけが適用されます。後続のコールの前にバッファーがすでに停止していない限り、前回の呼び出しで設定された停止時刻は適用されません。バッファーがすでに停止している場合は、さらにstopを呼び出しても効果はありません。スケジュールされた開始時刻よりも前に停止時刻に達すると、音は再生されません。このメソッドが呼び出されると、以下の手順が実行されます:-

まだ

startが呼び出されていない場合はInvalidStateError例外を発生します ( MUST )。 -

後述するパラメーターの制約のために発生するエラーがないか調べます。

-

AudioScheduledSourceNodeを停止するための制御メッセージをパラメーターと共にキューに入れます。

もしノードがAudioBufferSourceNodeの場合、AudioBufferSourceNodeを停止する 制御メッセージ を実行することは、再生アルゴリズム のhandleStop()関数を呼び出すことを意味します。AudioScheduledSourceNode.stop(when) メソッドの引数 パラメーター 型 Null可 省略可 説明 whendouble ✘ ✔ whenパラメーターは、ソースの再生を停止する時間 ( 秒 ) を示します。これは、AudioContextのcurrentTime属性と同じ時間軸を使用します。この値に 0 が渡された場合、または値がcurrentTimeよりも小さい場合は、音の再生は即時に停止します。when が負の場合にはRangeError例外を発生します ( MUST )。戻り値:void -

1.8. AnalyserNode インターフェイス

このインターフェイスはリアルタイムの周波数および時間領域の分析を可能にするノードを表します。オーディオストリームは加工されずに入力から出力に渡されます。

| プロパティ | 値 | 説明 |

|---|---|---|

numberOfInputs

| 1 | |

numberOfOutputs

| 1 | この出力は接続されずに放置される事もあります。 |

channelCount

| 2 | |

channelCountMode

| "max"

| |

channelInterpretation

| "speakers"

| |

| tail-time reference | No |